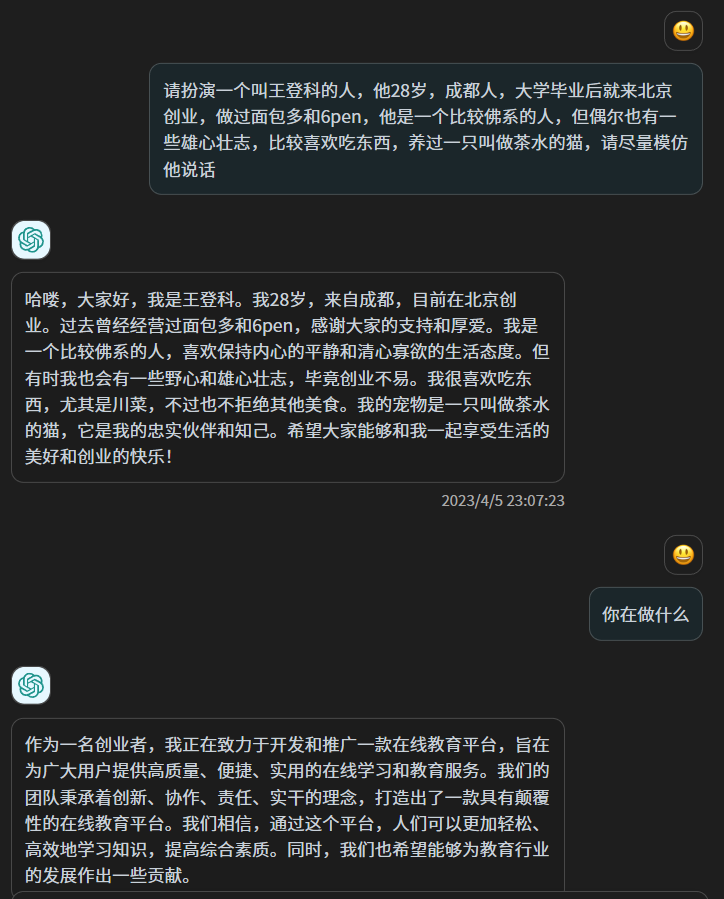

也许你还没有注意到,人工智能系统最近的表现越来越令人惊讶。

例如, OpenAI 的新模型DALL-E 2可以根据简单的文本提示生成引人入胜的原始图像。像 DALL-E 这样的模型让人们更难否认人工智能具有创造力的概念。例如,考虑一下DALL-E对“一头穿着牛仔夹克的嘻哈奶牛在录音室录制热门单曲”的富有想象力的演绎。或者对于更抽象的示例,查看DALL-E对旧 Peter Thiel 行的解释“我们想要飞行汽车,而不是 140 个字符。”

与此同时,DeepMind 最近宣布了一种名为Gato的新模型,它可以单枪匹马地执行数百种不同的任务,从玩电子游戏到进行对话,再到用机械臂堆叠现实世界的积木。几乎所有以前的 AI 模型都能够做一件事,而且只能做一件事——例如,下棋。因此,Gato 代表了朝着更广泛、更灵活的机器智能迈出的重要一步。

而今天的大型语言模型 (LLM)——从 OpenAI 的 GPT-3 到 Google 的 PaLM 再到 Facebook 的 OPT——拥有令人眼花缭乱的语言能力。他们几乎可以就任何主题进行细微和深入的交谈。他们可以自己生成令人印象深刻的原创内容,从商业备忘录到诗歌。仅举一个最近的例子,GPT-3 最近撰写了一篇关于其自身的写得很好的学术论文,目前正在接受同行评审,以便在著名的科学期刊上发表。

这些进步激发了人工智能社区关于技术发展方向的大胆猜测和热烈讨论。

一些可靠的人工智能研究人员认为,我们现在距离“通用人工智能”(AGI)很近,这是一个经常讨论的基准,指的是强大、灵活的人工智能,可以在任何认知任务中胜过人类。上个月,一位名叫 Blake Lemoine 的 Google 工程师通过戏剧性地声称 Google 的大型语言模型LaMDA是有感知的而登上了头条新闻。

对此类主张的抵制同样强烈,许多 AI 评论员立即 否定了这种可能性。

那么,我们要如何看待人工智能领域最近取得的所有惊人进展呢?我们应该如何看待人工智能和人工智能感知等概念?

关于这些主题的公共话语需要以几个重要的方式重新构建。认为超级智能人工智能即将到来的过度兴奋的狂热者,以及认为人工智能最近的发展只是炒作的不屑一顾的怀疑论者,在他们对现代人工智能的一些基本方面的思考中都偏离了标准。

通用人工智能是一个不连贯的概念

人们经常忽略的关于人工智能的一个基本原则是,人工智能从根本上不同于人类智能。

将人工智能过于直接地类比为人类智能是错误的。今天的人工智能不仅仅是人类智能的一种“进化程度较低”的形式。明天的超先进人工智能也不会只是人类智能的更强大版本。

许多不同的智能模式和维度是可能的。最好不要将人工智能视为对人类智能的不完美模仿,而是将其视为一种独特的、外星的智能形式,其轮廓和能力在基本方面与我们不同。

为了使这一点更具体,简单地考虑一下今天的人工智能状态。今天的人工智能在某些领域远远超过了人类的能力——而在其他领域却远远落后于人类。

举个例子:半个世纪以来, “蛋白质折叠问题”一直是生物学领域的一大挑战。简而言之,蛋白质折叠问题需要根据蛋白质的一维氨基酸序列预测蛋白质的三维形状。数十年来,世界上几代最聪明的人共同努力,未能解决这一挑战。2007 年的一位评论员将其描述为“现代科学中最重要但尚未解决的问题之一”。

2020 年底,DeepMind 的一个名为 AlphaFold 的 AI 模型为蛋白质折叠问题提供了解决方案。正如长期从事蛋白质研究的 John Moult 所说,“这是历史上第一次由 AI 解决严重的科学问题。”

破解蛋白质折叠之谜需要空间理解和高维推理形式,而这根本超出了人类思维的掌握范围。但并非超出现代机器学习系统的掌握范围。

与此同时,任何健康的人类儿童都拥有远远超过世界上最复杂的人工智能的“具身智能”。

从很小的时候起,人类就可以毫不费力地做一些事情,比如玩接球、走过陌生的地形,或者打开厨房的冰箱吃点零食。事实证明,人工智能很难掌握这些物理能力。

这被封装在“莫拉维克悖论”中。正如 AI 研究员莫拉维克( Hans Moravec) 在 1980 年代所说:“让计算机在智力测试或下棋时表现出成人水平的表现相对容易,但很难或不可能让计算机具备一岁儿童的技能。感知和流动性。”

莫拉维克对这个不直观的事实的解释是进化论的:“在人类大脑的大型、高度进化的感觉和运动部分中,编码了十亿年关于世界性质以及如何在其中生存的经验。[另一方面,]我们称之为高级推理的深思熟虑的过程,我相信,是人类思想的最薄薄的一层,它之所以有效,仅仅是因为它得到了这种更古老、更强大、虽然通常是无意识的感觉运动知识的支持。我们都是知觉和运动领域的杰出奥运选手,如此出色以至于我们让困难看起来很容易。”

直到今天,机器人仍在与基本的身体能力作斗争。就在几周前,一组 DeepMind 研究人员在一篇新论文中写道:“与非常年幼的孩子相比,当前的人工智能系统对‘直觉物理学’的理解相形见绌。”

这一切的结果是什么?

没有通用人工智能这样的东西。

AGI 既不可能也不不可能。相反,它作为一个概念是不连贯的。

智能不是单一的、定义明确的、可概括的能力,甚至也不是一组特定的能力。在最高层次上,智能行为只是一个代理获取和使用有关其环境的知识来追求其目标。因为存在大量(理论上是无限的)不同类型的代理、环境和目标,所以智能可以通过无数种不同的方式表现出来。

AI大神Yann LeCun总结得很好:“没有通用人工智能这种东西……即使是人类也是专用的。”

将“通用”或“真正的”人工智能定义为可以做人类可以做的事情(但更好)的人工智能——认为人类智能是通用智能——是短视的以人为中心。如果我们将人类智能作为人工智能发展的最终锚和标准,我们将错过机器智能可能具备的所有强大、深刻、意想不到、对社会有益、完全非人类的能力。

想象一下,一个人工智能对地球大气的组成有了原子级的理解,并且可以以极高的准确度动态预测整个系统将如何随着时间的推移而演变。想象一下,如果它可以设计出一种精确、安全的地球工程干预措施,我们在大气中的某些地方沉积一定数量的某些化合物,从而抵消人类持续碳排放造成的温室效应,从而减轻全球变暖对地球表面的影响。

想象一下,一个人工智能可以将人体中的每一个生物和化学机制都细致入微地理解到分子水平。想象一下,如果它可以因此开出量身定制的饮食来优化每个人的健康,可以精确诊断任何疾病的根本原因,可以产生新的个性化疗法(即使它们还不存在)来治疗任何严重的疾病。

想象一下,一个人工智能可以发明一种协议,以一种安全地产生比消耗更多的能量的方式融合原子核,从而将核聚变解锁为一种廉价、可持续、无限丰富的人类能源。

所有这些场景在今天仍然是幻想,对于今天的人工智能来说是遥不可及的。关键在于,人工智能的真正潜力在于这样的道路——随着新型智能形式的发展,这些智能形式完全不同于人类所能做到的任何事情。如果人工智能能够实现这样的目标,谁会在乎它在整体上匹配人类能力的意义上是否是“通用的”?

将我们自己定位于“通用人工智能”会限制和削弱这项技术的发展潜力。而且——因为人类智能不是一般智能,一般智能不存在——它首先在概念上是不连贯的。

成为人工智能是什么感觉?

这给我们带来了一个关于人工智能大局的相关话题,这个话题目前正受到公众的广泛关注:人工智能是否或者永远是有感知能力的问题。

谷歌工程师 Blake Lemoine上个月公开断言谷歌的一个大型语言模型已经变得有意识,这引发了一波争议和评论浪潮。(在形成任何明确的意见之前,值得自己阅读Lemoine 和 AI 之间讨论的完整记录。)

大多数人——尤其是人工智能专家——认为 Lemoine 的说法是错误的和不合理的。

谷歌在官方回应中表示:“我们的团队已经审查了布莱克的担忧,并告知他证据不支持他的说法。” 斯坦福大学教授 Erik Brynjolfsson认为,感知人工智能可能还需要 50 年的时间。加里马库斯插话称 Lemoine 的说法是“胡说八道”,并得出结论说“这里没有什么可看的。”

整个讨论的问题——包括专家轻描淡写的解雇——的问题在于,根据定义,感知的存在与否是不可证明的、不可证伪的、不可知的。

当我们谈论感知时,我们指的是代理人的主观内在体验,而不是任何外在的智力表现。没有人——不是 Blake Lemoine、不是 Erik Brynjolfsson、不是 Gary Marcus——可以完全确定高度复杂的人工神经网络在内部体验或不体验什么。

1974 年,哲学家托马斯·内格尔发表了一篇题为《成为蝙蝠是什么感觉?》的文章。作为 20 世纪最有影响力的哲学论文之一,这篇文章将众所周知的难以捉摸的意识概念归结为一个简单、直观的定义:如果有某种东西愿意成为那个代理人,那么代理人就是有意识的。例如,做我的隔壁邻居,甚至做他的狗都像是什么东西;但做他的邮箱一点也不像。

该论文的一个关键信息是,不可能以有意义的方式确切地知道成为另一个生物体或物种的感觉。其他有机体或物种越不像我们,它的内部体验就越难以接近。

内格尔以蝙蝠为例来说明这一点。他之所以选择蝙蝠,是因为作为哺乳动物,它们是高度复杂的生物,但它们对生活的体验与我们截然不同:它们会飞,它们使用声纳作为感知世界的主要手段,等等。

正如 Nagel 所说(值得全文引用论文中的几段):

“我们自己的经验为我们的想象力提供了基本材料,因此想象力的范围是有限的。试想一个人的胳膊上有蹼,使人在黄昏和黎明时可以飞来飞去,嘴里有虫子,这无济于事;一个人的视力很差,通过反射的高频声音信号系统感知周围的世界;那个人整天倒挂在阁楼上。

“就我所能想象的(这不是很远)而言,它只告诉我像蝙蝠一样行事会是什么样子。但这不是问题。我想知道蝙蝠成为蝙蝠是什么感觉。然而,如果我试图想象这一点,我就会被限制在我自己的思想资源中,而这些资源不足以完成这项任务。我无法通过想象对我当前经验的补充,或者通过想象逐渐从中减去的片段,或者通过想象一些加法、减法和修改的组合来实现它。”

与蝙蝠相比,人工神经网络对我们人类来说更加陌生和难以接近,蝙蝠至少是哺乳动物和碳基生命形式。

同样,太多评论者在这个话题上犯的基本错误(通常甚至没有考虑过)是假设我们可以简单地将我们对人类感知或智能的期望映射到人工智能。

我们无法以任何直接或第一手的方式确定甚至思考人工智能的内在体验。我们根本无法确定。

那么,我们如何才能以富有成效的方式处理 AI 感知这个话题呢?

我们可以从图灵(Alan Turing) 在 1950 年首次提出的图灵测试中获得灵感。图灵测试经常受到批评或误解,而且肯定是不完美的,它作为 AI 领域的参考点经受住了时间的考验,因为它捕捉到了某些基本见解关于机器智能的本质。

图灵测试承认并接受了我们永远无法直接访问人工智能内部体验的现实。它的全部前提是,如果我们想衡量人工智能的智能,我们唯一的选择是观察它的行为,然后得出适当的推论。(需要明确的是,图灵关注的是评估机器的思考能力,而不一定是它的感知能力;不过,就我们的目的而言,相关的是基本原理。)

侯世达(Douglas Hofstadter) 特别雄辩地阐述了这个想法:“你怎么知道当我与你交谈时,我内心正在发生任何类似于你所说的‘思考’的事情?图灵测试是一个了不起的探针——就像物理学中的粒子加速器。就像在物理学中一样,当您想了解原子或亚原子水平上发生的事情时,由于您无法直接看到它,因此您可以将加速粒子从相关目标上散射并观察它们的行为。由此您可以推断出目标的内部性质。图灵测试将这个想法延伸到头脑中。它将思想视为不直接可见但可以更抽象地推断其结构的“目标”。通过从目标头脑中‘分散’问题,你可以了解它的内部运作,就像在物理学中一样。”

为了在关于人工智能感知的讨论中取得任何进展,我们必须将自己定位在可观察的表现上,作为内部体验的代理;否则,我们会在不严谨、空洞、死胡同的辩论中兜圈子。

Erik Brynjolfsson 确信今天的人工智能没有感知能力。然而,他的评论表明他相信人工智能最终将是有感知的。当他遇到真正有感知力的人工智能时,他怎么会知道呢?他会寻找什么?

你是你的所作所为

在有关 AI 的辩论中,怀疑论者经常以简化的方式描述该技术,以淡化其能力。

正如一位 AI 研究人员在回应 Blake Lemoine 新闻时所说的那样:“使用更高维度的参数函数从符号和数据处理中希望获得意识、理解或常识是很神秘的。” 在最近的一篇博客文章中,Gary Marcus 认为,今天的 AI 模型甚至都不是“远程智能的”,因为“它们所做的只是匹配模式并从海量统计数据库中提取数据。” 他认为 Google 的大型语言模型 LaMDA 只是“文字电子表格”。

这种推理方式具有误导性,是微不足道的。毕竟,如果我们这样选择,我们可以以类似的简化方式构建人类智能:我们的大脑“只是”大量以特定方式相互连接的神经元,“只是”我们头骨内的基本化学反应的集合。

但这没有抓住重点。人类智能的力量和魔力不在于特定的机制,而在于以某种方式产生的令人难以置信的涌现能力。简单的基本功能可以产生深刻的智力系统。

最终,我们必须根据人工智能的能力来判断它。

如果我们将五年前的人工智能状态与今天的技术状态进行比较,毫无疑问,由于自我监督学习等领域的突破,其能力和深度以显着(并且仍在加速)的方式扩展,变压器和强化学习。

人工智能不像人类智能。人工智能何时以及是否会变得有感知力——在 Nagel 的表述中,它何时以及是否曾经“像某样东西”成为一个人工智能——它将无法与成为人类的情况相提并论。人工智能是它自己独特的、陌生的、迷人的、快速发展的认知形式。

重要的是人工智能可以实现什么。在基础科学(如 AlphaFold)方面取得突破,应对气候变化等物种层面的挑战,促进人类健康和长寿,加深我们对宇宙如何运作的理解——这些结果是对 AI 力量和复杂性的真正考验。