近日,生成式AI又火了!一个叫做「盗梦师」的微信小程序,上线一鸣惊人,达成了日增5万新用户的纪录。

盗梦师是一个能根据输入文本生成图片的AI平台,属于AIGC(AI-Generated Content,即人工智能生成内容)的分支。

在用户发挥想象,输入文字描述后,盗梦师便可生成1:1、9:16和16:9三种比例的图片,还有24种绘画风格可以选择——除了基础的油画、水彩、素描等绘画种类,还包括赛博朋克、蒸汽波、像素艺术、吉卜力和 CG 渲染等特别风格。

图:科技云报道编辑用「盗梦师」微信小程序生成

事实上,这并不是第一款“以文生图”的AI软件。从Midjourney到Stable Diffusion,生成式AI一直是近两年最炙手可热的话题。

作为AI发展的一个重要方向,生成式AI具有非常大的发展潜力。

据Gartner上半年的数据,预计到 2025 年,生成式AI将占所有生成数据的10%,当前这一比例不到1%。

有观点认为,2022年将是生成式AI从技术成熟到深入社会基本面的元年。

生成式AI爆发式增长:从图片到视频

最近几年,AI技术在视觉领域的发展可谓是“神速”。

去年1月,致力于“用通用人工智能造福全人类”的OpenAI公司,基于GPT-3模型发布了划时代的DALL-E,实现了从文本生成图像。

今年4月份,OpenAI发布的第二代DALL-E 2模型,再次为图像生成领域树立了全新标杆。

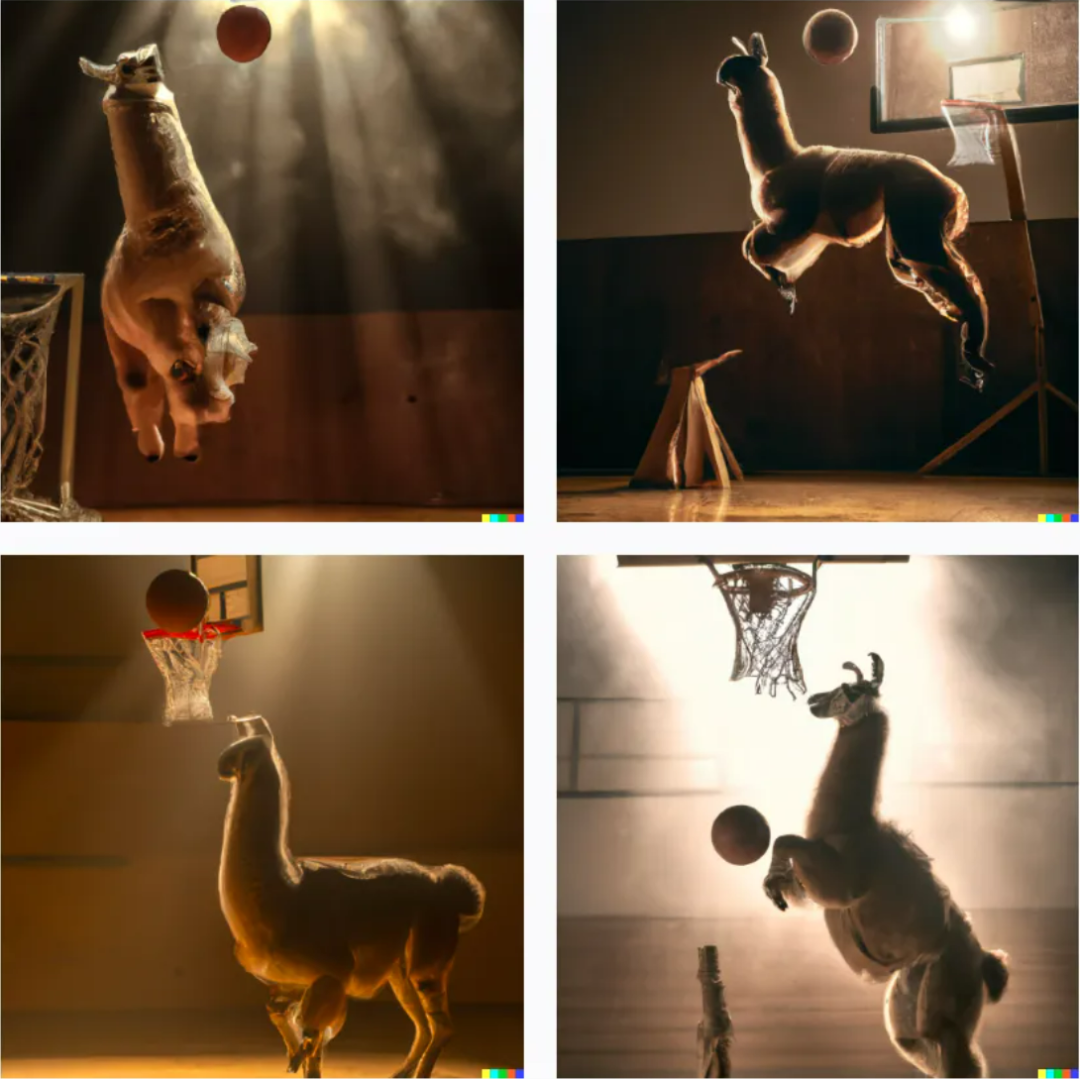

用户可以通过简短的文本描述(prompt)来生成相应的图像,使得不会画画的人也可以将自己的想象力变为艺术创作,例如“羊驼打篮球”这句话生成的四张图片,看起来就非常符合大家预期的想象。

DALL-E 2模型生成图片示例

不仅如此,随着文字描述的颗粒度不断细化,生成的图像也会越来越精准,效果在非专业人士看来已经相当震撼。

但DALL-E 2这样的模型仍然停留在二维创作即图片生成领域,无法生成360度无死角的3D模型。

不过这依旧难不住极具创意的算法研究员,Google Research的一项最新成果——DreamFusion模型,即可通过输入简单的文本提示生成3D模型,不仅能够在不同的光照条件下进行渲染,而且生成的3D模型还具有密度、颜色等特性,甚至可以把生成的多个3D模型融合到一个场景里。

在生成3D图片之后,Meta的算法人员将思路进一步打开,向更高难度发起挑战,开始探索用文字提示来直接生成视频。

虽然本质上来说,视频就是一系列图像的叠加,但相比于生成图像,用文字来生成视频时,不仅需要生成相同场景下的多个帧,还要保证相邻帧之间的连贯性。由于训练模型时可用的高质量视频数据非常少,但计算量却很大,大大增加了视频生成任务的复杂性。

今年9月,来自Meta的研究人员发布了Make-A-Video,这是一个基于人工智能的高质量短视频生成模型,相当于视频版的DALL-E,也被戏称为“用嘴做视频”,即可以通过文本提示创建新的视频内容,其背后使用的关键技术,也同样来自DALL-E等图像生成器所使用的“文本-图像”合成技术。

仅1周之后,谷歌CEO皮查伊就接连官宣了两个模型,来正面挑战Meta的Make-A-Video,分别是Imagen Video与Phenaki。

与Make-A-Video相比,Imagen Video更加突出视频的高清特性,能生成1280*768分辨率、每秒24帧的视频片段,还能理解并生成不同艺术风格的作品;

理解物体的3D结构,在旋转展示中不会变形;

甚至还继承了Imagen准确描绘文字的能力,在此基础上仅靠简单描述产生各种创意动画。

Imagen Video生成视频示例

而Phenaki则能根据200个词左右的提示语生成2分钟以上的较低分辨率长镜头,讲述一个相对完整的故事。

Phenaki生成视频示例

目前,国内也有不少生成式AI的应用。

例如,字节跳动旗下的剪映APP提供AI生成视频功能,并可以免费使用。

剪映的图文成片功能和谷歌类似,创作者可以通过几个关键词或一小段文字,生成一段创意小视频。

剪映还可以根据文字描述智能匹配视频素材,将视频包装为更垂直的内容作品,包括财经、历史、人文等类别。

2022年1月,网易推出一站式AI音乐创作平台“网易天音”,将用户编辑的新年祝福AI生成为歌曲,并在上半年推出了web端专业版。

2021年9月,彩云小梦APP上线,能够进行各种类型文本创作,用户只需要给出一个1-1000字的开头,彩云小梦就能续写出后面的故事。

事实上,AI创作还有多种形式。当生成式AI技术应用于写稿,可以诞生机器版的记者、小说家、诗人、编剧等,而当它应用于绘画、音乐和舞蹈领域时,则可以“培养”出画家、作曲家和编舞人员。

生成式AI爆发的背后

过去一年里,生成式AI发展得更好了。谷歌、微软、Meta等AI领域的软件巨头们已在内部推进该技术,让生成式AI融合到自己的产品里。

为什么生成式AI突然就火了?

其实生成式AI技术一直在快速发展中,只不过之前因过高的技术门槛,多囿于科技界的小圈层。

回顾AI技术的发展历程,会发现生成式AI的爆发离不开三个因素:更好的模型、更多的数据,和更多的计算。

2015年以前,小模型被认为是理解语言的“最先进技术”。这些小模型,擅长分析任务,并被部署在从预测交付时间到欺诈分类的工作中。

然而,对于通用的生成任务,它们的表达能力还不够强。生成人类水平的写作或者代码,仍只是一个梦想。

2017年,谷歌研究院发布了一篇里程碑式的论文(Attention is All You Need),描述了一种用于自然语言理解的新神经网络架构,称为 transformers,可以生成质量上乘的语言模型,同时,具有更高的可并行性,需要的训练时间也大大减少。

当然,随着模型越来越大,它们开始显现出超越人类的水平。从2015年到2020年,用于训练这些模型的计算量增加了6个数量级,其结果在手写、语音和图像识别、阅读理解以及语言理解方面,超过了人类性能的基准。

其中,OpenAI的GPT-3脱颖而出,该模型的性能比GPT-2有了巨大飞跃,从代码生成到冷笑话写作,显示了更优秀的能力。

尽管有所有基础研究领域的进展,这些模型并不普遍。

它们体积大、运行困难(需要GPU协调),不能广泛使用(不可用或仅有封闭的测试版),而且作为云服务使用的费用昂贵。

但是尽管有这些限制,最早的生成性AI应用开始进入战场。

之后,随着计算变得更便宜,业界继续开发更好的算法和更大的模型。

开发者的权限从封闭测试版扩大到了开放测试版,或者在某些情况下,开放源代码。

如今,平台层的稳固,加上模型继续变得更好、更快、更便宜,以及模型的访问趋向于免费和开源,AI应用层的创造力爆发时机已经成熟。

比如,今年8月,文本-图像生成模型Stable Diffusion开源,后继者能更好地借助这一开源工具,挖掘出更丰富的内容生态,为向更广泛的C端用户普及起到至关重要的作用。

Stable Diffusion的火爆,本质上就是开源释放了创造力。

生成式AI面临现实挑战

风投机构红杉资本在官网上的一篇博客文章中提到:“生成式AI有潜力产生数万亿美元的经济价值。

”据红杉资本预测,生成式AI可以改变每个需要人类创造原创作品的行业,从游戏到广告再到法律。

具体而言,未来生成式AI的应用场景非常广阔,除了文创、新闻等内容生产行业外,生成式AI在医疗保健、数字商业、制造业、农业等多个行业都有丰富的应用前景,如帮助医生检测X射线、CT等设备扫描中的病变、创建商品的数字孪生体、辅助检测产品质量等。

在XR、数字孪生、自动驾驶汽车等热门技术上也有丰富的应用空间。

但值得注意的是,当前生成式AI仍有很多问题需要解决。

如在文娱领域,不少人采用生成式AI进行创作的一个原因,就是可以避免版权问题,但这并不代表没有隐患。

一方面,AI的创作也是将学习到数据按照要求重新组合起来,虽然颗粒度越来越细,但难免还是有眼尖的人会看出可能是参考了哪些作品,甚至有网友在社交平台上表示曾在某AI生成图片上隐约看到疑似签名的痕迹。

另一方面,当前大部分AI生成平台多不主张版权或明确表示可以进行商用,但随着生成式AI逐步商业化,这样的版权环境是否存在,是否会出现新的版权问题也是需要讨论的。

生成式AI的逻辑与安全性也有待提升。当前的生成式AI很容易犯一些常识性的错误,在一些需要长期记忆的地方也容易出现问题。

如在AI生成小说的过程中,经常会因为篇幅较长而出现前后矛盾的地方。

因此,即便生成式AI已经可以在很多领域得到应用,真要让生成式AI投入工作,还要通过大量的训练来避免因AI的“错误”造成的重大损失。

毕竟医疗、制造业这些应用场景没有文创行业那样的试错空间。

结语

尽管生成式AI当前还离不开人工干预,但不可否认的是,生成式AI仍具有非常大的发展潜力。

生成式AI的出现,意味着AI开始在现实内容中,承担从“观察、预测”拓展到“直接生成、决策”的新角色。换句话说,生成式AI是在创造,而不仅仅是分析。

正如OpenAI CEO Sam Altman所说:“生成式AI提醒我们,很难做出有关于人工智能的预测。

十年前传统观点认为:人工智能首先会影响体力劳动;然后,是认知劳动;然后,也许有一天它可以做创造性的工作。现在看起来,它会以相反的顺序进行。”