GPT4发布在即堪比人脑,多位圈内大佬坐不住了!

作者 | 徐杰承

审校 | 云昭

100万亿,这个数字究竟有多大?假如你拥有每天都能中500万彩票的超能力,那么在不吃不喝存下所有钱的情况下,你还需要拥有约5500年的寿命,才能够攒下100万亿的财产。然而,今天想要和大家聊的这100万亿,背后并不是“RMB”、“Dollor”这些令人垂涎的单位。这里的100万亿,指的是由众多硅谷科技大亨共同创立的人工智能研究公司OpenAI即将发布的第四代生成式预训练Transformer——GPT-4所拥有的参数量。

为了方便大家更加直观的理解这个数据,我们可以用人脑与GPT-4进行对比。一般情况下,一个正常人类的大脑约有800—1000亿个神经元,以及约100万亿个突触。而这些神经元与突触,几乎直接控制着一个人百年人生中的所有思想、判断及行为,而GPT-4拥有与人脑突触一样多的参数。那么,如此庞大规模的密集神经网络究竟具备着怎样的潜力;GPT-4的出现将会给我们的带来哪些惊喜;我们又是否已经真的具备制造人脑的能力了呢?

在探索这些令人兴奋的问题之前,我们不妨先来了解一下GPT-4几位“前辈”的发展历史。

1、GPT:不鸣则已,一鸣惊人

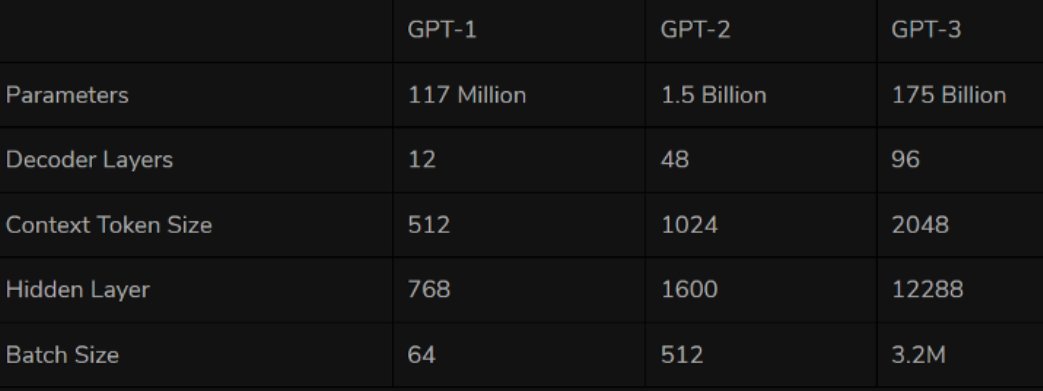

首个GPT系列模型GPT-1诞生于2018年,也就是我们常说的NLP预训练模型元年。GPT-1作为第一个基于Transformer的预训练模型,采取了预训练+FineTuning两个阶段,以Transformer的decoder作为特征抽取器,共堆叠12层,拥有1.1亿参数,预训练阶段则采用“单向语言模型”作为训练任务。

性能方面,GPT-1有着一定的泛化能力,能够用于和监督任务无关的NLP任务中。其常用任务包括:

- 自然语言推理:判断两个句子的关系(包含、矛盾、中立)

- 问答与常识推理:输入文章及若干答案,输出答案的准确率

- 语义相似度识别:判断两个句子语义是否相关

- 分类:判断输入文本是指定的哪个类别

虽然GPT-1在未经调试的任务上有一些效果,但其泛化能力远低于经过微调的有监督任务,因此GPT-1只能算得上一个还算不错的语言理解工具而非对话式AI。

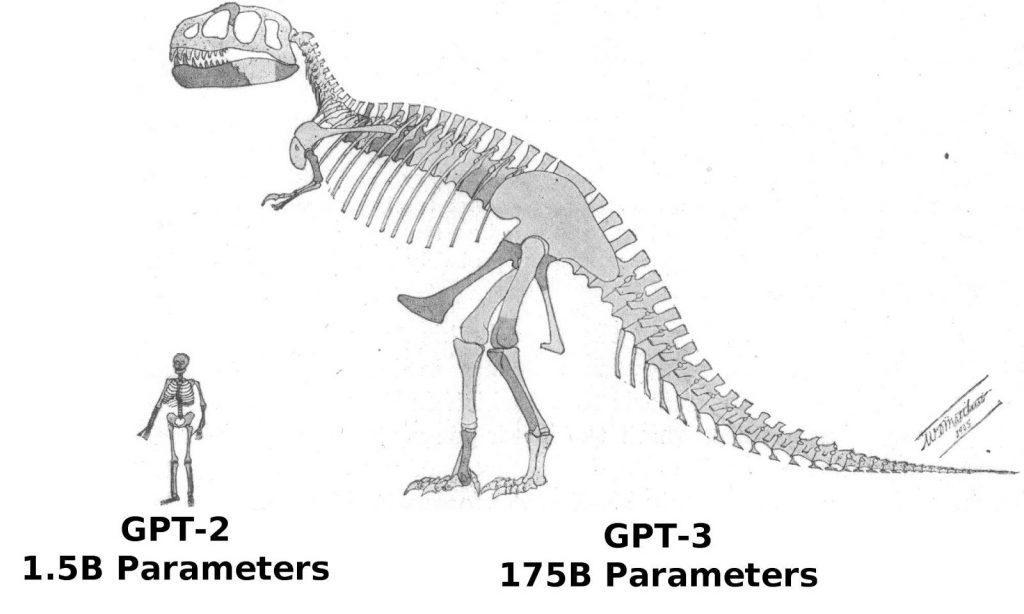

在GPT-1问世一年之后,GPT-2也于2019年如期而至。相比于老大哥GPT-1,GPT-2并没有对原有的网络进行过多的结构创新与设计,只使用了更多的网络参数与更大的数据集:最大模型共计48层,参数量达15亿,学习目标则使用无监督预训练模型做有监督任务。

图源:推特

在性能方面,OpenAI的大力似乎真的带来了一些奇迹。除了理解能力外,GPT-2在生成方面第一次表现出了强大的天赋:阅读摘要、聊天、续写、编故事,甚至生成假新闻、钓鱼邮件或在网上扮演他人通通不在话下。在“变得更大”之后,GPT-2的确展现出了一些列普适而强大的能力,并在多个特定的语言建模任务上实现了彼时的最佳性能。也难怪当时OpenAI曾表示“GPT-2 was too dangerous to release”。

自GPT-2取得成功以来,OpenAI对“大力神教”的信仰愈发坚定,2020年放出的GPT-3继续沿用微创新、猛扩大的发展思路。除了GPT-3中的Transformer应用了Sparse结构外,GPT-3与GPT-2的结构几乎没有区别。而在“大力”方面,GPT-3的模型上到了96层,训练参数则是达到了1750亿个(GPT-2的10倍以上)。

而GPT-3也再次证明了OpenAI的眼光,由于GPT-3更强的性能和明显更多的参数,它包含了更多的主题文本,显然优于前代的GPT-2。作为目前最大的密集型神经网络,GPT-3能够将网页描述转换为相应代码、模仿人类叙事、创作定制诗歌、生成游戏剧本,甚至模仿已故的各位哲学家——预测生命的真谛。且GPT-3不需要微调,在处理语法难题方面,它只需要一些输出类型的样本(少量学习)。可以说GPT-3似乎已经满足了我们对于语言专家的一切想象。

2、全面通过图灵测试学习和商用门槛降低

说到这里,相信大家一定会有一个相同的疑问——GPT-3已经非常强大了,那么GPT-4还有哪些值得我们期待的地方呢?

众所周知,测试一个AI系统智能性的最核心方式便是图灵测试,在我们还无法用科学的可量化标准对人类智慧这一概念进行定义时,图灵测试是目前为数不多的、可行的、能够确定对方是否具备人类智慧的测试方法。用一句谚语来说:如果一个东西长的像鸭子,走路像鸭子,叫起来像鸭子,那它就是鸭子。因此,如果AI系统能够顺利通过图灵测试,那么就意味着这个系统已具备人类思维并有可能在某些方面替代人类。而根据韩国IT媒体报道,自11月中开始,业界已经传出了GPT-4全面通过了图灵测试的说法。韩国Vodier AI公司高层南世东在日前接受韩国《经济新闻》采访时表示:“虽然GPT-4通过图灵测试的消息尚未正式确认,但这个消息应该相当可信。”

技术人出身,现任OpenAI CEO的Sam Altman似乎也在其Twitter中证实了这个信息。Altman在11月10日模仿电影《星球大战》中角色达斯维德的经典台词,发出了一条推文:“不要为你制造的这种技术恐慌感到骄傲。通过图灵测试的能力在‘原力’面前也无能为力”。

图源:推特

一位AI初创公司的高管分析称“如果GPT-4真的完美通过了图灵测试,那么它的影响足以在AI界引发‘技术恐慌’,因此Altman才会借由达斯维德的角色来公布这个信息”。

如果GPT-4在没有任何限制的情况下通过图灵测试,这的确将会创造历史。虽然此前一些AI模型也曾声称通过图灵测试,但都未曾得到过AI业界的一致认可。这是由于图灵测试的标准和规则并不明确,因此许多模型都在测试中巧妙地利用了一些“盲点”。英国雷丁大学在2014年推出的AI模型“尤金”就是一个典型的例子,当时雷丁大学对评委声称,该模型是一位13岁的乌克兰男孩,因此当算法无法给出很好的答案时,评委会认为这是由于被测试者是外国儿童的缘故。

图源:网络

虽然图灵测试并不是AI技术的绝对参考点,但作为迄今为止最久远、最广为人知的AI技术测试,图灵测试仍然有着很大的象征意义。如果GPT-4真的正式且肯定的通过了图灵测试,那么它将极有可能创造迄今为止AI界最大的一座里程碑。

除此之外,与GPT-3不同的是,GPT-4将很有可能不仅只是一个语言模型。OpenAI首席科学家Ilya Sutskever曾在其撰写的多模态相关文章中暗示过这一点——“文字本身即可表达关于这个世界的大量信息,但毕竟是不完整的,因为我们也生活在视觉世界之中。”因此,业界部分专家认为GPT-4将会是多模态的,可以接受音频、文本、图像甚至是视频输入,并预测OpenAI的Whisper的音频数据集将用于创建GPT-4所需的文本数据。这也意味着GPT-4对于外界信息的接收与处理将不会再有任何局限性。

而工业界关注GPT-4的原因,则很有可能是由于GPT-4的实际商用门槛将比传统GPT-3更低。此前由于巨额费用和基础设施原因而未能使用相关技术的企业也将有望使用GPT-4。目前GPT-4已进入上市的最后阶段,将于今年12月至明年2月期间发布。剑桥AI研究公司分析师Alberto Garcia通发表了博客并预测:“GPT-4将更专注于优化数据处理,因此GPT-4的学习成本预计将低于GPT-3。GPT-4的每集学习成本将可能由GPT-3的数百万美元将至100万美元左右”。

3、殊途同归:模拟人脑或来得更快

如果以上信息全部属实,那么此刻我们可以预见,随着GPT-4的发布,明年深度学习研究领域将迎来一轮新的热潮;各个行业中将可能出现大量更加高级、更加自然且几乎无法辨别其身份真伪的聊天服务机器人;在此基础上,也将会有更多高质量的个性化AI服务从不同的传统业务中诞生;我们也将极有可能第一次实现与认知智能的无障碍交流。

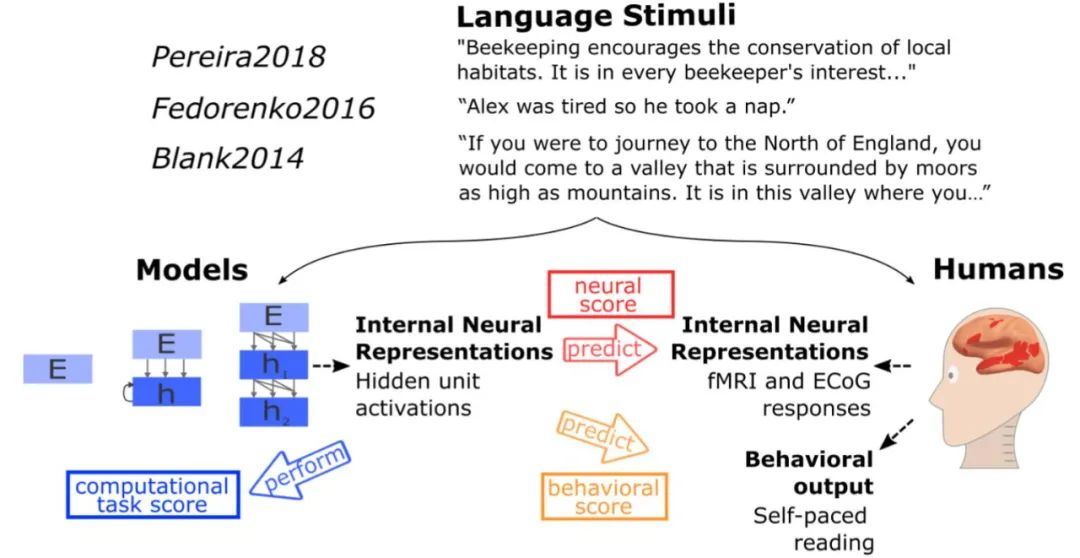

再说回开篇提到的制造人脑或者说模拟人脑的问题。据MIT的一项研究显示,虽然GPT-3中的神经网络并没有试图直接模仿人类大脑,但GPT-3所呈现出的语言处理方式与人类大脑进化过程所得到的解决方案存在一定的相似性,当向模型输入与测试人脑相同的刺激时,模型获得了与人脑同类型的激活,且在40余种语言模型测试中,GPT-3几乎做出了完美的推断,这些模型的基本功能的确类似于人类大脑语言处理中心的功能。对此,斯坦福大学心理学和计算机科学助理教授Daniel Yamins也表示:“人工智能网络并没有直接模仿大脑,但最终看起来却像大脑一样,这在某种意义上表明,人工智能和自然之间似乎发生了某种趋同演化”。

图源:网络

由此可见,虽然GPT系列模型并没有直接采用蓝脑计划项目中的模拟大脑结构的设计思路,但其呈现出的效果似乎比蓝脑计划项目更加接近我们的期望。因此,如果这一研究方向真的切实可行,且GPT-4能够在GPT-3的基础上实现某些方面的跨越性突破,那么我们距离模拟人脑的部分功能的目标将更进一大步。

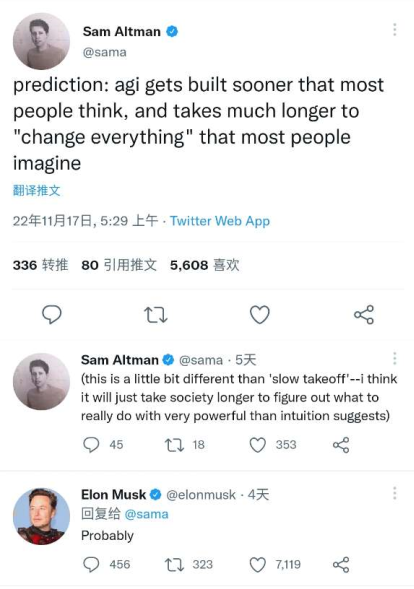

最后,我想引用OpenAI CEO Sam Altman近期在Twitter上发表的一段文字作为结尾,而这段话也得到了“硅谷钢铁侠”Elon Musk的认可——“通用人工智能的建立会比大多数人想象的更快,并且它会通过很长的时间来‘改变’大多数人想象中的一切”。

图源:推特

参考链接:

https://dzone.com/articles/what-can-you-do-with-the-openai-gpt-3-language-mod

https://analyticsindiamag.com/gpt-4-is-almost-here-and-it-looks-better-than-anything-else/

https://analyticsindiamag.com/openais-whisper-might-hold-the-key-to-gpt4/