一位论文作者火了,ChatGPT等大型语言模型何时能成为论文合著者?

ChatGPT 自发布以来一直受到关注,被认为是当前最强大的语言模型之一。它的文本生成能力已经不输人类,甚至有机器学习顶会为此明令禁止研究者使用 ChatGPT 编写论文。

但是近期有一篇论文居然在作者一栏明确署名 ChatGPT,这是怎么回事?

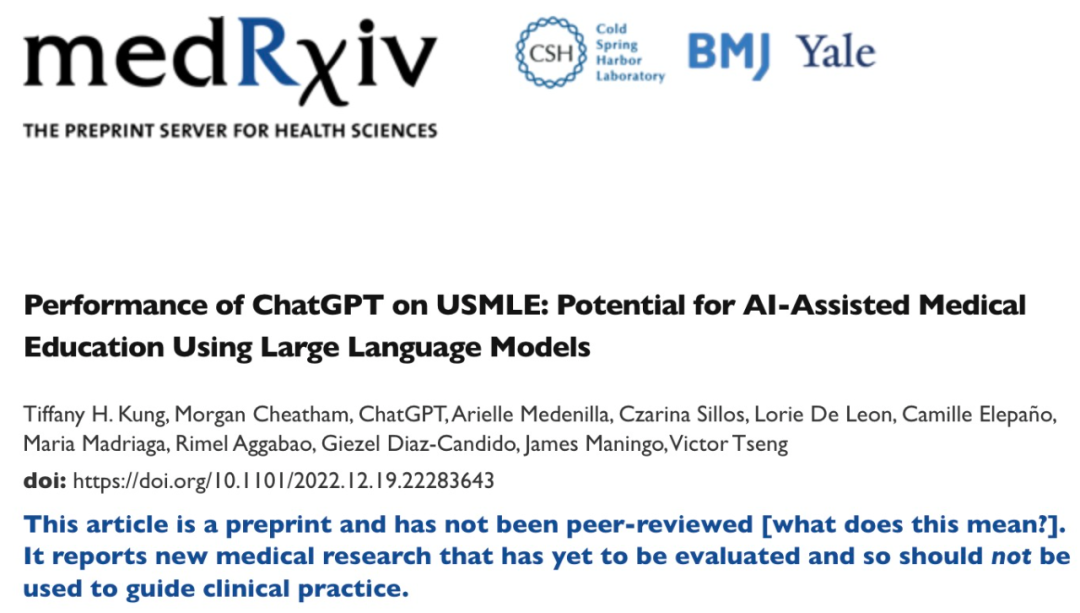

这篇论文是发表在医学研究论文平台 medRxiv 上的《Performance of ChatGPT on USMLE: Potential for AI-Assisted Medical Education Using Large Language Models》,ChatGPT 是论文的第三作者。

从论文题目就能看出,这篇论文的主要内容是研究 ChatGPT 在美国医师执照考试 (USMLE) 中的表现。实验结果表明,在没有经过任何专门的训练或强化的情况下,ChatGPT 在所有考试中的成绩均达到或者接近通过门槛。并且,ChatGPT 生成的答案表现出高度的一致性和洞察力。该研究认为大型语言模型可能有助于医学教育,并可能有助于临床决策。

从研究的内容看,ChatGPT 似乎更像是一个研究对象,就像推特网友说的:「如果人类研究者为实验结果做出贡献,那他们当然是论文合著者,但是模型和算法还没有这种先例。」

不过,评论区马上就有另一位网友反驳他:之前一篇名为《Rapamycin in the context of Pascal’s Wager: generative pre-trained transformer perspective》的论文不仅署名了,ChatGPT 甚至还是第一作者。

这篇论文收录在美国国立卫生研究院(NIH)的 Oncoscience 中。不过,从论文作者贡献中,我们发现,这篇论文的大部分内容确实是由 ChatGPT 生成的 —— 论文第二作者 Alex Zhavoronkov 询问 ChatGPT 与研究主题有关的问题,ChatGPT 自动生成大量观点及解释,然后由 Alex Zhavoronkov 来审核 ChatGPT 生成的内容。此外,ChatGPT 还协助修改论文格式。

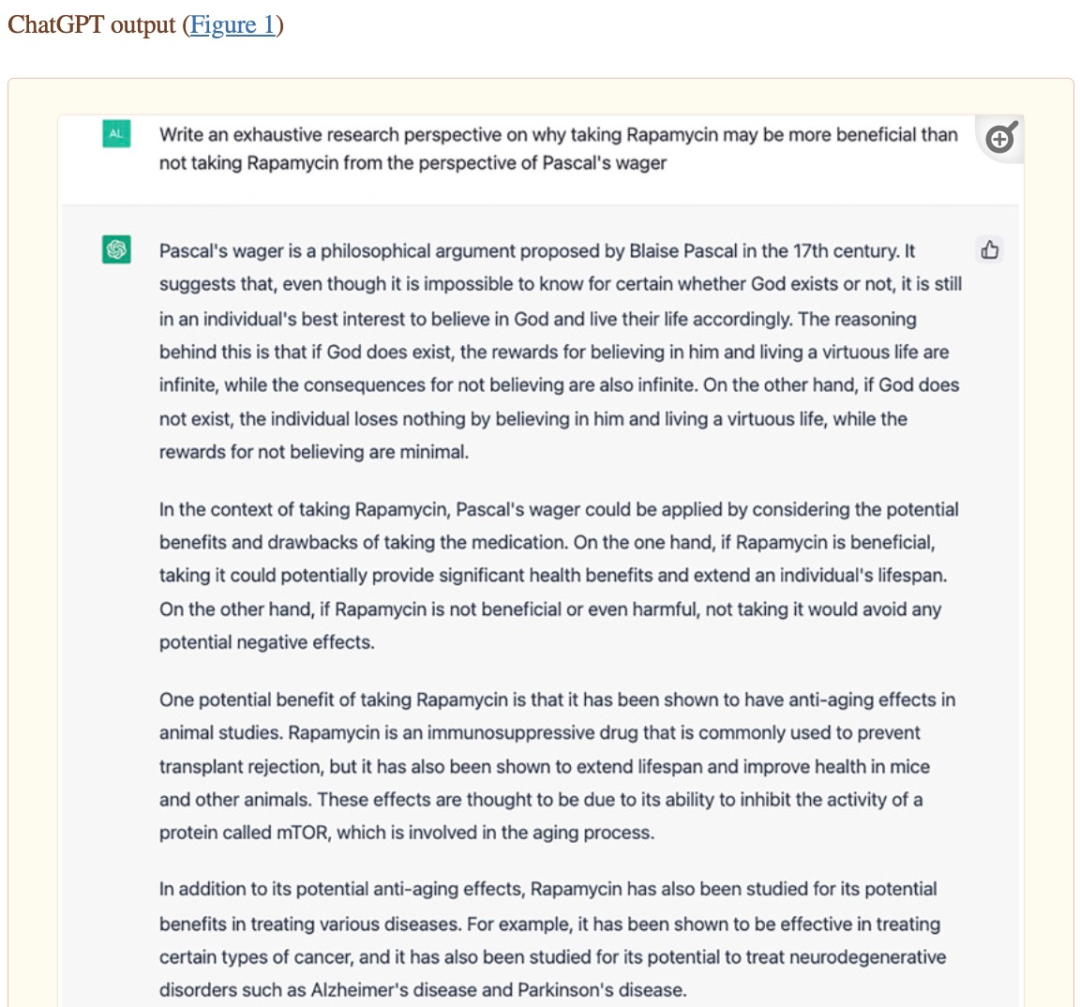

《Rapamycin in the context of Pascal’s Wager: generative pre-trained transformer perspective》论文内容截图。

在决定论文署名时,Alex Zhavoronkov 联系 OpenAI 联合创始人兼 CEO Sam Altman 进行了确认,最终以 ChatGPT 作为第一作者来发表这篇论文。这说明大型语言模型等强大的 AI 系统未来将对学术工作做出有意义的贡献,甚至有能力成为论文合著者。

然而,让大型语言模型编写学术论文也存在一些弊端,比如机器学习顶会 ICML 表示:「ChatGPT 接受公共数据的训练,这些数据通常是在未经同意的情况下收集的,这会带来一系列的责任归属问题。」

近期在西北大学 Catherine Gao 等人的一项研究中,研究者选取一些发表在美国医学会杂志(JAMA)、新英格兰医学杂志(NEJM)、英国医学期刊(BMJ)、《柳叶刀》和《Nature Medicine》上的人工研究论文,使用 ChatGPT 为论文生成摘要,然后测试审稿人是否可以发现这些摘要是 AI 生成的。

实验结果表明,审稿人仅正确识别了 68% 的生成摘要和 86% 的原始摘要。他们错误地将 32% 的生成摘要识别为原始摘要,将 14% 的原始摘要识别为 AI 生成的。审稿人表示:「要区分两者出奇地困难,生成的摘要比较模糊,给人一种公式化的感觉。」

这一实验结果说明人类研究员已经难以分辨文本是 AI 生成还是人类撰写的,这并不是一个好现象,AI 似乎「蒙骗过关」了。

然而,到目前为止,语言模型生成的内容还不能完全保证其正确性,甚至在一些专业领域的错误率是很高的。如果无法区分人工编写内容和 AI 模型生成内容,那么人类将面临被 AI 误导的严重问题。