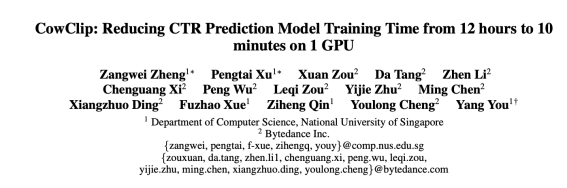

模型训练提速72倍,NUS与字节合作成果入选AAAI2023杰出论文

近日,人工智能国际顶会AAAI 2023公布评选结果。新加坡国立大学(NUS)与字节跳动机器学习团队(AML)合作的CowClip技术论文入围杰出论文(Distinguished Papers)。CowClip是一项模型训练优化策略,可以在保证模型精度的前提下,实现在单张GPU上的模型训练速度提升72倍,相关代码现已开源。

论文地址:https://arxiv.org/abs/2204.06240

开源地址:https://github.com/bytedance/LargeBatchCTR

AAAI是由国际人工智能促进协会主办的年会,是人工智能领域中历史最悠久的顶级学术会议之一。AAAI 2023共收到8777篇论文投稿,其中1721篇论文被录用,录用率为19.6%。牛津大学计算机科学系获得此次大会的最高奖项(Outstanding Paper Award),北大等机构合作论文则获得学生论文奖(Outstanding Student Paper)。此外,大会还评选出12篇杰出论文(Distinguished Papers),内容涵盖模型训练策略优化、图神经网络优化、神经架构搜索等多个方向。

如何提升模型训练速度是机器学习领域永恒的课题。自从谷歌在2018年提出首个预训练大模型BERT,大模型训练逐渐成为深度学习领域的潮流和趋势。然而,模型体量越来越大也意味着一次完整的训练要花费大量的时间和计算成本。根据此前谷歌发布的信息,训练110亿参数的 T5(谷歌 2019 年推出的预训练模型)变体时,单次运行成本超过130万美元。

入选杰出论文的CowClip模型训练优化策略,通过保障更大批量大小(batch size)的模型精度,可以实现更加充分的GPU性能挖掘,达到提高训练速度的目的。实验显示,利用 CowClip 训练的模型比其它方法不仅精度更高,训练速度也大幅提升,在单张GPU上训练Deep FM模型可以针对公开数据集的数据,将训练时间从12小时压缩至10分钟,一次性将模型训练速度提升72倍。

凭借高效的计算和更加精准的分析与决策能力,人工智能技术正越来越广泛地应用到医疗、金融、制造、教育和电商等领域,而模型训练的精度和效率将持续成为影响人工智能产业发展的关键因素。

据介绍,字节跳动机器学习团队(AML)已将CowClip的核心技术在公司部分业务中落地实践。该团队为公司提供机器学习中台服务,包括为今日头条、抖音、西瓜视频等产品的推荐、广告、搜索等业务场景提供大规模训练系统和推理系统,并通过火山引擎向企业客户提供简单易用、稳定可靠的机器学习平台。