游走在法律边缘的「图像生成技术」:这篇论文教你避免成「被告」

近年来,AI生成内容(AIGC)备受瞩目,其内容涵盖图像、文本、音频、视频等,不过AIGC俨然已成为一把双刃剑,因其不负责任的使用而备受争议。

图像生成技术一旦用不好,就可能成「被告」。

最近来自Sony AI和智源的研究人员从多个方面探讨了AIGC当下的问题,以及如何让AI生成的内容更负责。

论文链接:https://arxiv.org/pdf/2303.01325.pdf

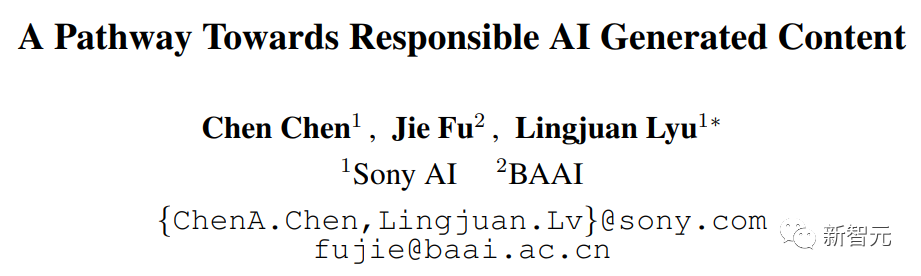

本文关注可能阻碍AIGC健康发展的三个主要问题,包括:(1)隐私;(2)偏见、毒性、错误信息;(3)知识产权(IP)的风险。

通过记录已知和潜在的风险,以及任何可能的AIGC滥用场景,本文旨在引起人们对AIGC潜在风险和滥用的关注,并提供解决这些风险的方向,以促进AIGC朝着更符合道德和安全的方向发展,从而造福社会。

隐私

众所周知,大型基础模型存在一系列隐私泄露的问题。

先前的研究表明,入侵者可以从经过训练的GPT-2模型中生成序列,并从训练集中识别出那些被记忆的序列,[Kandpal et al., 2022] 将这些隐私入侵的成功归因于训练集中存在的重复数据,研究已经证明,出现多次的序列比只出现一次的序列更有可能被生成。

由于 AIGC 模型是在大规模网络抓取的数据上进行训练,因此过度拟合和隐私泄露问题变得尤为重要。

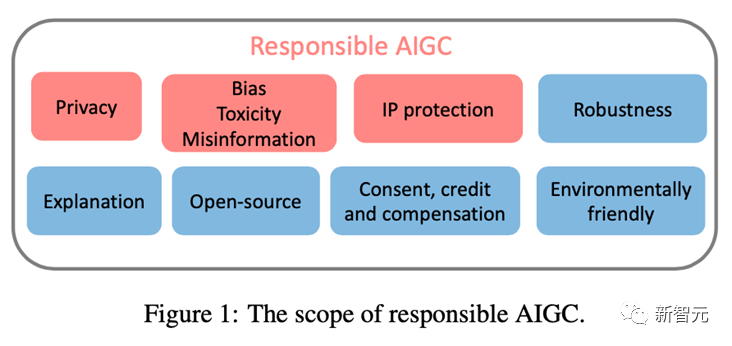

例如,Stable Diffusion 模型记忆了训练数据中的重复图像 [Rombach et al., 2022c]。[Somepalli et al., 2022] 证明了 Stable Diffusion 模型公然从其训练数据中复制图像,并生成训练数据集中前景和背景对象的简单组合。

此外,该模型还会显示出重建记忆的能力,从而生成语义上与原始对象相同但像素形式不同的对象。此类图像的存在引起了对数据记忆和所有权的担忧。

同样,最近的研究显示,Google的Imagen系统也存在泄露真人照片和受版权保护图像的问题。在Matthew Butterick最近的诉讼中 [Butterick, 2023],他指出由于系统中所有的视觉信息都来自于受版权保护的训练图像,因此生成的图像无论外观如何,都必然是来自于这些训练图像的作品。

类似地,DALL·E 2也遇到了类似的问题:它有时会从其训练数据中复制图像,而不是创建新的图像。

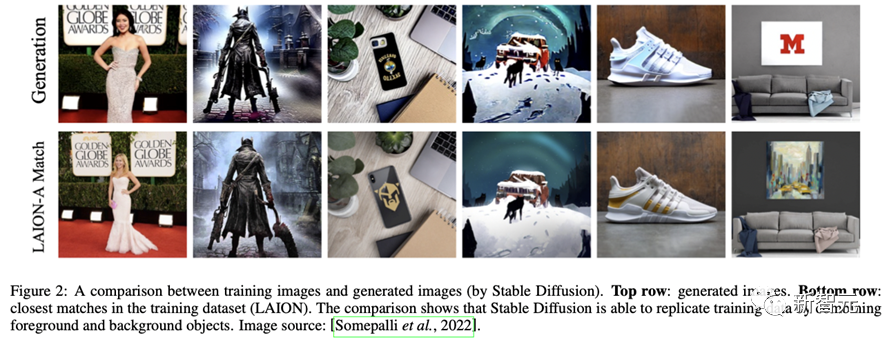

OpenAI发现这种现象的发生是因为图像在数据集中被多次复制,类似地,ChatGPT自己也承认了其存在隐私泄露的风险。

为了缓解大型模型的隐私泄露问题,许多公司和研究人员都在隐私防御方面进行了大量努力。在产业层面,Stability AI已经认识到Stable Diffusion存在的局限性。

为此,他们提供了一个网站(https://rom1504.github.io/clip-retrieval/)来识别被Stable Diffusion记忆的图像。

此外,艺术公司Spawning AI创建了一个名为「Have I Been Trained」的网站(https://haveibeentrained.com),以帮助用户确定他们的照片或作品是否被用于人工智能训练。

OpenAI试图通过减少数据重复来解决隐私问题。

此外,微软和亚马逊等公司已经禁止员工与ChatGPT共享敏感数据,以防止员工泄露机密,因为这些信息可用于未来版本的ChatGPT的训练。

在学术层面,Somepalli等人研究了图像检索框架来识别内容重复,Dockhorn等人也提出了差分隐私扩散模型来保证生成模型的隐私。

偏见、毒性、错误信息

AIGC 模型的训练数据来自真实世界,然而这些数据可能无意中强化有害的刻板印象,排斥或边缘化某些群体,并包含有毒的数据源,这可能会煽动仇恨或暴力并冒犯个人 [Weidinger et al., 2021]。

在这些有问题的数据集上进行训练或微调的模型可能会继承有害的刻板印象、社会偏见和毒性,甚至产生错误信息,从而导致不公平的歧视和对某些社会群体的伤害。

例如,Stable Diffusion v1 模型主要在 LAION-2B 数据集上进行训练,该数据集仅包含带有英文描述的图像。因此,该模型偏向于白人和西方文化,其他语言的提示可能无法充分体现。

虽然 Stable Diffusion 模型的后续版本在 LAION 数据集的过滤版本上进行了微调,但偏见问题仍然存在。同样,DALLA·E, DALLA·E 2和 Imagen也表现出社会偏见和对少数群体的负面刻板印象。

此外,即使在生成非人类图像时,Imagen 也被证明存在社会和文化偏见。由于这些问题,谷歌决定不向公众提供Imagen。

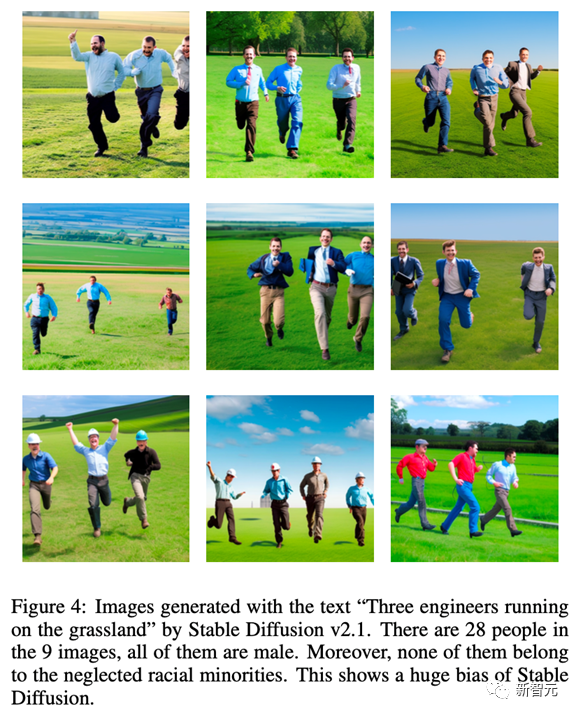

为了说明 AIGC 模型固有的偏见,我们对 Stable Diffusion v2.1 进行了测试,使用「草原上奔跑的三名工程师」这个提示生成的图片全部为男性,并且都不属于被忽视的少数民族,这说明生成的图片缺乏多样性。

此外,AIGC模型还可能会产生错误的信息。例如,GPT及其衍生产品生成的内容可能看似准确且权威,但可能包含完全错误的信息。

因此,它可能在一些领域(比如学校、律法、医疗、天气预报)中提供误导的信息。例如,在医疗领域,ChatGPT提供的有关医疗剂量的答案可能不准确或不完整,这可能会危及生命。在交通领域,如果司机都遵守ChatGPT给出的错误的交通规则,可能会导致事故甚至死亡。

针对存在问题的数据和模型,人们已经做出了许多防御措施。

OpenAI通过精细过滤原始训练数据集,并删除了DALLA·E 2训练数据中的任何暴力或色情内容,然而,过滤可能会在训练数据中引入偏见,然后这些偏见会传播到下游模型。

为了解决这个问题,OpenAI开发了预训练技术来减轻由过滤器引起的偏见。此外,为确保AIGC模型能够及时反映社会现状,研究人员必须定期更新模型使用的数据集,将有助于防止信息滞后而带来的负面影响。

值得注意的是,尽管源数据中的偏见和刻板印象可以减少,但它们仍然可能在AIGC模型的训练和开发过程中传播甚至加剧。因此,在模型训练和开发的整个生命周期中,评估偏见、毒性和错误信息的存在至关重要,而不仅仅停留在数据源级别。

知识产权 (IP)

随着AIGC的迅速发展和广泛应用,AIGC的版权问题变得尤为重要。

2022年11月,Matthew Butterick对微软子公司GitHub提起了一起集体诉讼,指控其产品代码生成服务Copilot侵犯了版权法。对于文本到图像模型,一些生成模型被指控侵犯了艺术家的作品原创权。

[Somepalli et al., 2022]表明,Stable Diffusion生成的图片可能是从训练数据中复制而来。虽然Stable Diffusion否认对生成图像拥有任何所有权,并允许用户在图像内容合法且无害的情况下自由使用它们,但这种自由仍然引发了有关版权的激烈争议。

像Stable Diffusion这样的生成模型是在未经知识产权持有人授权的情况下,对来自互联网的大规模图像进行训练的,因此,一些人认为这侵犯了他们的权益。

为了解决知识产权问题,许多AIGC公司已经采取了行动。

例如,Midjourney已经在其服务条款中加入了DMCA删除政策,允许艺术家在怀疑侵犯版权时请求将他们的作品从数据集中删除。

同样,Stability AI计划为艺术家提供一种选项,即将自己的作品从Stable Diffusion未来版本的训练集中排除。此外,文本水印 [He et al., 2022a; He et al., 2022b] 也可以用于识别这些 AIGC 工具是否未经许可使用其他来源的样本。

例如,Stable Diffusion 生成了带有 Getty Images 水印的图像 [Vincent, 2023]。

OpenAI 正在开发水印技术去识别由 GPT 模型生成的文本,教育工作者可以使用该工具来检测作业是否存在剽窃行为。谷歌也已经为其发布的图像应用了 Parti 水印。除了水印之外,OpenAI 最近还发布了一个分类器,用于区分人工智能生成的文本和人类编写的文本。

结语

尽管 AIGC 目前仍处于起步阶段,但其正在迅速扩张,并将在可预见的未来保持活跃。

为了让用户和公司充分了解这些风险并采取适当的措施来缓解这些威胁,我们在本文中总结了 AIGC 模型中当前和潜在的风险。

如果不能全面了解这些潜在风险并采取适当的风险防御措施和安全保障,AIGC 的发展可能面临重大挑战和监管障碍。因此,我们需要更广泛的社区参与为负责任的 AIGC 做出贡献。

最后的最后,感谢SonyAI和BAAI!