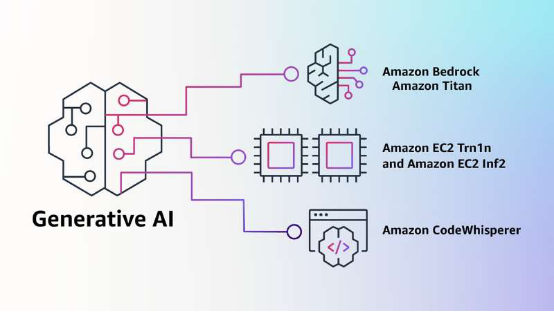

如今,AIGC 无疑是最火热的话题之一。国内外各大科技企业纷纷追随,推出自家的大模型以及相关应用产品。近日,亚马逊云科技推出了生成式 AI 领域的四大创新,致力于推动技术的普惠化,希望将AIGC技术从研究和试验领域释放,让更多公司都可以从中受益。

亚马逊云科技大中华区产品部总经理陈晓建在采访中表示,“我们的使命是让各种技能水平的开发人员和各种规模的组织都有机会使用生成式 AI 进行创新。亚马逊云科技提供的四大能力,希望可以降低各行各业的客户使用生成式 AI 的技术门槛和资金门槛,能够让更多的人更容易地、更有性价比地使用生成式 AI。”

Amazon Bedrock:降低模型使用门槛

一般情况下,企业在使用大模型时,需要找到最适合企业业务场景的大模型,并且可以和企业的业务程序无缝集成。然而,很多企业不具备能力和时间来搭建一个全新环境来训练自己的大模型。为此,亚马逊云科技推出全新的生成式AI全托管服务 Amazon Bedrock,用户通过API 调用方式即可访问亚马逊云科技和第三方基础模型提供商的预训练基础模型(Foundation model),从而降低用户在大规模训练和部署方面的使用门槛。

据了解,Amazon Bedrock 具有四大优势。第一,Amazon Bedrock 是全托管的服务,用户无需担心后端所使用的各种基础资源的申请、管理和各种运营的服务,这些工作都是由亚马逊云科技来执行。

其次,Amazon Bedrock 预设了五大模型,包括亚马逊云科技所开发的两大基础模型Amazon Titan Text 和 AmazonTitan Embeddings,以及三个第三方合作伙伴的模型,用户可以为其场景选择最适合自己应用场景的模型。由于现在市场变化很快,各家都有大模型,客户希望找到更加适用于他们行业和业务的模型。为此,亚马逊云科技根据客户的需求帮助客户挑选行业领先的模型,包括 Stability AI、Anthropic 和 AI21 Labs 三个外部模型。Stability AI 模型更偏向于多模态的文生图或者自然语言能生成图片;Anthropic Claude 则更多地关注对话文字生成;AI21 Labs 模型在多语言支持上表现比较好,包括小语种以及文章的文本摘要等方面。

第三,Amazon Bedrock 可以帮助用户定制模型。每个用户的场景需求和业务逻辑都不同,用户也需要通过自身积累的业务数据来训练一个最适合的场景模型。亚马逊云科技在 Amazon Bedrock 中特意加强了数据训练的隐私和安全性,确保数据安全和隐私保护的前提下,用户可以使用自身的数据来对模型进行定制。

第四,在安全加密方面,所有用户的环境都基于自身的 VPC(私有网络环境),与其他客户完全隔离,同时所有数据都进行加密。这意味着用户不仅可以使用 Amazon Bedrock,还可以方便且安全地使用亚马逊云科技的各种类型云服务,对整个业务进行定制化改造。

亚马逊云科技大中华区数据技术专家团队总监王晓野表示,Amazon Bedrock 是亚马逊云科技主导和运营的模型平台,也向业内领先的其他模型提供商开放,未来也有可能加入更多领先模型。但是需要强调的是,Amazon Bedrock 并不是一个开放的模型市场,亚马逊云科技不会将其规模无限扩大。

Titan 模型:基础模型普惠化

此次亚马逊云科技推出的 Titan 模型,包括 Titan Text 和 Titan Embeddings 两种模型。Titan Text 是基于总结文本生成、分类、开放式回答和信息提取等任务的生成式大语言模型。Titan Embeddings 是一个文本嵌入式的大语言模型,能够把文本的输入翻译成包含语义的数字表达。虽然该大模型不生成文本,但是它对于个性化推荐和搜索等等应用程序非常有帮助的。相比于文字,编码可以帮助模型反馈更加相关、更符合情境的结果。

为了实现负责任的 AI 的实践,Titan 基础模型已经预设了很多功能,用于识别和删除用户提交的数据中的一些有害的内容,拒绝用户输入不当的内容,过滤模型中包括不当内容的输入结果,比如说仇恨、脏话和语言暴力等等。目前,已经有客户预览了亚马逊云科技全新的 Titan 基础模型,未来几个月,亚马逊云科技会进一步扩展其使用范围。王晓野强调,Titan 模型只有通过 Amazon Bedrock 才能使用。

自研芯片:降低训练和推理成本

日前,亚马逊云科技宣布了 Amazon EC2 Trn1n 和 Inferentia2 两个实例的正式可用。Trn1 是亚马逊云科技自研的训练芯片 Trainium 所支持的计算实例,这次推出的 Trn1n 是一个网络增强型的新实例,相比于 Trn1 网络带宽提升了 1 倍,达到 1.6 TB,旨在为大型的网络密集型的模型训练来使用。

在推理芯片方面,亚马逊云科技推出了 Inferentia2 实例,相比第一代芯片不仅吞吐量提升了 4倍、延迟降低了 10 倍,还实现了加速器之间的超高速网络连接,并且将云中推理成本降到最低。

众所周知,训练大模型需要花费高额成本,那么亚马逊云科技是如何提升性价比呢?陈晓建举例道,BERT 是众多训练环境中常用的一种。一个简单的 BERT 环境,如果基于英伟达的 GPU 实例并使用 16 个节点,简单的模型训练可能需要 13 个小时。在亚马逊云科技内部测试中,基于亚马逊云科技自研的 Trainium 训练芯片,同样使用 16 个节点,只要 5 个小时就可以完成模型训练。因此,自研芯片可以帮助用户实现数倍的性价比提升。

同样,针对大模型部署方面,例如基于 NLP 流行的模型,如果把同样模型部署到基于 GPU的环境之中,需要有 8 个 GPU 卡才能完成。但是如果使用 Inferentia2,同样的负载只需要 4 个 Inferentia2 芯片就可以完成。在整个硬件部署的环境、复杂性和成本资金等方面都有效降低,大大帮助用户降低成本和复杂性,以更好地提升业务的性能。

Amazon CodeWhispere:AI编程助手

Amazon CodeWhisperer 可以实时生成代码的建议,是目前唯一一个具备安全扫描的 AI编程助手,可以用于发现一些非常难以查找的漏洞,并且提出补救建议。目前,Amazon CodeWhisperer 针对个人开发者完全免费。此外,Amazon CodeWhisperer 可以过滤掉一些可能认为有偏见或者不公平的代码,并且还是唯一一个可以对可疑的开源代码进行过滤和标记的编程助手。

王晓野介绍了 Amazon CodeWhisperer 的使用方法。Amazon CodeWhisperer 相当于一款插件,可以直接安装在现有的开发环境中,就可以享有 Amazon CodeWhisperer 的帮助。“在使用的时候,开发者可以通过注释的方式与 Amazon CodeWhisperer 交互。一般写代码的时候我们都会给自代码加注释,在注释写 “请帮我生成一段上传图片到云端的代码”,它就会给出这一段代码的建议,如果我们都接受的话,就只需要按一下Tab键,就相当于接受了建议。这样的交互体验使得 Amazon CodeWhisperer 更像是开发者的智能助手。同时,它也提供一些安全的扫描功能,例如检查开源授权等。”

大模型的未来格局

自成立之日起,人工智能一直是亚马逊关注的焦点,在未来将更加如此。亚马逊云科技已经帮助超过 10 万个不同规模和行业的客户,利用行业领先的能力进行机器学习和人工智能创新。我们现在将见证机器学习的下一波广泛应用,无论客户体验还是应用程序都有机会通过使用生成式 AI 进行重塑。

陈晓建认为,多模态的大模型肯定是未来的热点。“最后大模型能够活下来,能够成为真正可以为大家所使用,可能取决于市场化的情况。通过这些通用的模型,用户在此基础上发展适合自己场景的细分行业模型,最终可能会成为常态。”