有关通用人工智能需要知道的事项

最近,关于生成式人工智能工具的讨论越来越多,特别是在多个大型语言模型和图像生成器(如DALL-E或Midjourney)发布之后。

这些发明再次将通用人工智能(GPAI)置于人们的关注的目光下,并再次提出了诸如GPAI是否应该受到监管等假设性问题。

在人们进一步探索可能性之前,首先了解GPAI的概念,它的含义,它是什么时候引入的等等。

什么是通用人工智能?

两年前,也就是2021年4月,欧盟委员会推出了通用人工智能。最初的人工智能法案提案免除了通用人工智能创建者遵守一些法律文书和其他责任标准的责任。

原因是它只适用于高风险的人工智能,在法案中根据它们的用途和背景明确提到和解释了这一点。

另一项规定,即第28条,支持了这一主张,并建议通用人工智能开发人员只有在对人工智能系统进行重大调整或发展以用于高风险用途时才对合规负责。

但根据最近的报道,欧洲议会也在考虑对原始通用人工智能提供商的某些“义务”。

欧盟人工智能法案的基本目的是对使用人工智能开发和部署系统时所涉及的各种行为者链进行分类和分类。

以下是指导通用人工智能监管的5个考虑因素

《人工智能法案》对通用人工智能的做法是为解决全球人工智能危害建立监管基调的理想选择。随着最近公众对生成式人工智能的兴趣增加,监管立场也有可能过度适应当前的问题。

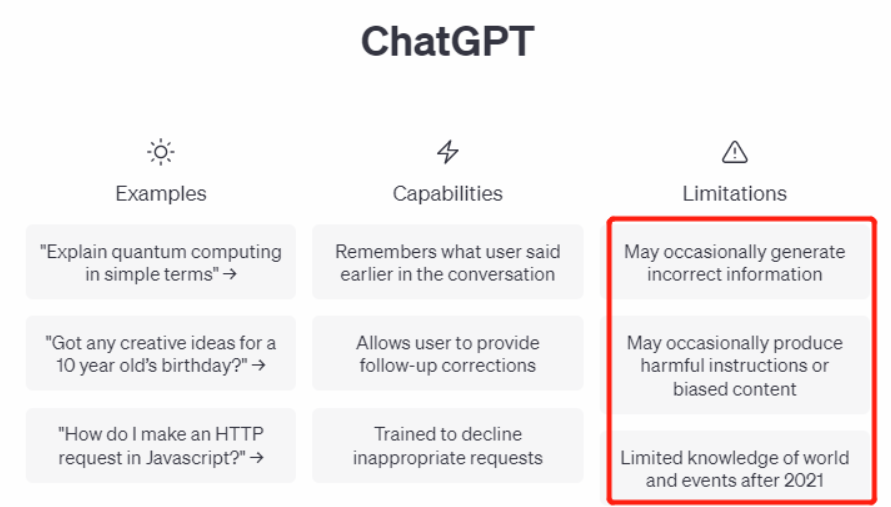

令人惊讶的是,ChatGPT、dall-e2和Bard等较新的创新甚至都不是真正的问题;事实上,它们只是冰山一角。

推荐:负责任的人工智能-如何在监管环境中采用道德模式

通用人工智能是一个庞大的类别

首先要理解的是,通用人工智能是一个巨大的类别,因此,将其应用于广泛的技术领域是合乎逻辑的,而不是将其局限于聊天机器人和法学硕士。

为了确保欧盟人工智能法案具有未来主义的性质,它必须涉及更大的规模。首先,GPAI的正确描述应该包括许多可以作为其他人工智能系统基础的技术(“任务”)。

欧盟理事会将其定义为:

“提供商打算执行一般适用的功能,如图像和语音识别、音频和视频生成、模式检测、问题回答、翻译等;通用人工智能系统可以在多个场景中使用,并且可以集成到多个其他AI系统中。”

通用人工智能可能造成广泛的危害

虽然这些风险不能在应用层中完全克服,但我们可以否认它们可能对各种应用程序和参与者产生影响的事实。我们应该在制定通用人工智能监管方法的同时,考虑人工智能技术的现状、应用及其工作方式。

例如,通用人工智能模型冒着产生反民主话语的风险,例如针对性、种族和宗教少数群体的仇恨言论。这些模型的风险在于,在它们的基础数据中固化了受约束或扭曲的观点。

通用人工智能应在整个产品生命周期内进行调节

为了让通用人工智能考虑到涉众的多样性,它必须在整个产品周期中进行治理,而不仅仅是在应用层。开发的第一个阶段是至关重要的,创建这些模型的业务必须对他们利用的信息和他们做出的体系结构决策负责。人工智能供应网络的现有架构有效地使参与者能够从远程下游应用程序中获利,同时避免因开发层缺乏监管而承担任何相应的责任。这包括数据的收集、清理和注释过程,以及模型的创建、测试和评估过程。

一个标准的法律免责声明是不够的

通用人工智能的创建者不可能使用基本的法律免责声明来免除他们的责任。这种方法可能导致一个危险的漏洞,它将释放原始开发人员的所有责任,而将责任放在下游参与者身上,他们没有能力管理所有风险。理事会的一般方法确实有一个例外,即允许通用人工智能开发人员免除自己的任何责任,只要他们在说明中排除所有高风险用途并确保系统不会被滥用。

推荐:发现、解决和揭穿隐藏的人工智能偏见

使非工业参与者、社会和研究人员参与更广泛的咨询

一个基本的、统一的文档实践来评估通用人工智能模型,特别是生成人工智能模型,跨越各种危害是一个正在进行的研究领域。为了避免肤浅的复选框练习,监管应防止狭隘的评估方法。

在实施或向公众提供通用人工智能系统之前,必须经过细致的警惕、验证和检查。最近的建议将通用人工智能模型纳入人工智能法案的范围,要么推迟制定未来的具体标准(由委员会决定),要么试图在人工智能法案的措辞中这样做。

例如,在一个达成一致的社会中,可能产生的影响的分布可能会有所不同,这取决于一个原型是为整个社区构建和使用的,还是为一个小社区使用的。

欧盟人工智能法案即将成为第一个广泛的人工智能法律,总有一天,它将成为所有国家的统一标准。这就是为什么处理人工智能领域并将其转化为每个人都可以遵循的全球模板至关重要的原因。