深入理解生成式AI技术原理:初识生成式AI

如果将人工智能按照用途进行简单分类的话,人工智能可以划分为决策式AI以及生成式AI两类。所谓决策式AI就是通过学习训练数据的中的条件概率分布情况来进行判断决策,判断样本属于指定目标的概率,比如人脸识别就是典型的决策式AI,终端设备根据摄像头获取到的人脸图像来进行特征信息匹配,和后台系统中的人脸特征库进行对比来判断当前人脸信息是否在系统人脸特征库中或者是否有权限执行操作。而以ChatGPT为代表的生成式AI通过对大量数据的联合概率进行学习,对已有的数据和知识进行归纳总结,同时结合深度学习技术,自动生成新的内容,而新生成的内容可以是文字、图片甚至是视频等多模态内容。本文主要简要介绍深度学习以及大模型基础内容,后续文章中将会继续深入分析这两方面的技术原理。

深度学习

深度学习是生成式AI背后比较核心的实现技术,它是机器学习的重要优化手段,而机器学习又是人工智能领域重要的落地实现措施。因此要想理解深度学习,我们先看下什么是机器学习,再来分析下它存在哪些不足才催生发展出来深度学习。关于机器学习有这样的定义。

怎么理解这句话呢?举个栗子大家瞬间就明白了,假如你开发了一个和别人下中国象棋的程序。那么E就表示下象棋的经验,T表示下象棋这件事情,而P就是下象棋可以取胜的概率。所以如果你编写的程序可以通过不断下象棋获得足够多的下象棋的经验,而通过经验的累积又能够提高下象棋获胜的概率,那么我们就可以认为你编写的下象棋的程序具备机器学习的能力。那么这种根据经验来实现程序学习能力优化提升到底是通过什么工程技术来实现的呢?人工神经网络就是通过工程技术手段来落地模拟人脑神经系统的结构和功能从而实现机器学习。

人工神经网络

仿生学一直是人类追求进步的工具,比如人类希望像鸟一样飞行于是发明了飞机,人类希望像鱼一样潜入水底于是发明了潜水艇,人类希望机器能够像人一样进行思考推理,于是开始研究自身大脑运行机理。人们发现自身大脑是由数百亿个神经元组成,这些神经元本身结构并不复杂,而这些神经元互相协作却能完成各项信息的接收处理以及输出,从而构成人的感知,记忆,分析,思考等高阶行为能力。而且随着人年龄的增长,学习能力也是在不断增强。因此如果可以设计出类似人类神经网络能力具备学习能力的系统,那么机器也会像人一样学习进步。实际上从本质上来看,我们可以将人类的大脑看作为一个信息处理器,视觉、听觉、触觉等都是大脑信息的输入信号,而大脑的神经元系统就是信息处理器处理各种输入信号给出对应的行为响应。

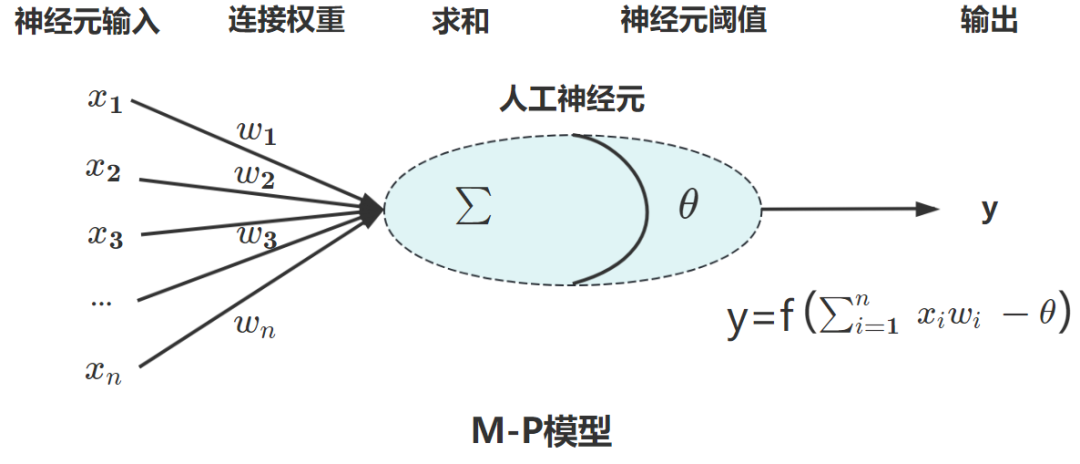

正因为受到了人脑神经元结构的启发,先驱们试图通过模拟人脑神经系统来让机器具备人类分析问题解决问题的智能行为。实际上早在1943年,数学家皮茨(Pitts)和麦卡洛克(McCulloch)就发表了论文《A Logical Calculus of Ideas Immanent in Nervous Activity》(《神经活动中思想内在性的逻辑演算》)揭开了人工神经网络研究的序幕。在这篇论文中提出了”人工神经元”抽象的数学模型(M-P Model)用以描述神经元的行为以及信息传递方式。

在M-P模型中,人工神经元可以接收来自外部的多个输入信号,每个输入信号与神经元之间的连接都有相应的连接权重,和生物学意义上的神经元类似,人工神经元同样拥有阈值,达到阈值才会激活神经元。而将将人工神经元进行收尾相连,如同大脑数以亿计的神经元网络,信息在不同的层级的神经元之间进行传递、处理以及抽象,这个过程我们就称之为思考。

此后在M-P模型基础之上,先驱们不但进行研究优化,海布学习规则、感知机学习以及适⽤于多层感知器的反向传播算法BP算法等都被相继提出,但是受限于计算机硬件算力的限制以及其他各种条件的影响。直到2006年,人工智能通过⽆监督的学习⽅法逐层训练算法,再使用有监督的反向传播算法进⾏调优,这种无监督学习和有监督学习相结合的方法在人工智能领域掀起了深度学习的研究浪潮,深度卷积神经网络架构AlexNet,循环神经网络(RecurrentNeuralNetworks,RNN)、长短期记忆网络(LongShort-TermMemory,LSTM)、生成式对抗网络(GenerativeAdversarialNetwork,GAN)等被相继提出。

如上图所示,对于机器学习来说它需要人工介入进行特征提取来帮助机器学习来实现分类处理,而深度学习不需要人工介入干预,自身便可以实现特征提取,这是两者最大的区别。

大模型

以前我们需要对大量标注过的数据进行训练,这样训练出来的模型都是专门应对某一领域的专才,就像AlphaGo一开始他只会下围棋,你让它下中国象棋它就不会了,如果需要它具备下中国象棋的技能就需要重新训练一套模型来支持。这就好比我们早期的烟囱式的技术架构,都是针对某一项特定的业务场景来进行系统平台的建设。但是随着大数据技术的发展、GPU强大算力支撑以及模型不断迭代优化带来了深度学习技术长足发展,特别是大模型出现之后可以以海量无标注的数据中进行自我学习来进行预训练 ,从而获得具备通用知识能力的大模型,而后再结合特定领域知识以及训练任务进行模型微调训练,让大模型成为某个领域的专家模型。比如结合医疗领域知识,那么就可以通过微调任务得到医疗领域模型,如果结合法律领域知识,那么就可以获取到法律领域模型,而不需要再重新训练一套模型。其实大模型的训练过程和我们人类学习的过程是一样的,我们小的时候语数外政治历史地理物理化学生物啥都学,但是到了大学开始分专业,到了研究生就在特定的专业领域进行深耕,最终成为一个专业人才。这个过程是不是和大模型的训练过程有异曲同工之妙。

总结

本文主要对生成型AI进行了初步阐述,同时针对生成型AI最核心的两个技术点分别进行了初步说明,后面的专栏文章中将继续以深度学习以及大模型核心技术点作为切入点来深入分析生成型AI背后的技术原理。希望通过系列文章的说明,让大家对于类似ChatGPT这样的生成型AI有一个更加深刻的理解。