早晚会有这一天,但它还是比想象来得早了一些:大模型在手机上运行的预言被实现了。

图片

图片

上个月的计算机视觉学术顶会 CVPR 上,生成式 AI 成了重要方向,高通会议中展示了一把未来有望成为「主流」的 AI 应用:用手机跑大模型 AI 画图。

CVPR 是 AI 领域最负盛名的重要会议,我们曾在其中见证过人工智能的几次重要突破,今年在获奖和入围的论文中,既有通用大模型,也有 AI 画图的研究,可谓一下进入了生成式 AI 的新时代。

图片

图片

在 CVPR 2023 上,高通共有八篇论文被主会议收录,并行的展示覆盖生成式 AI、计算机视觉、XR 和自动驾驶汽车等领域的理论创新,以及应用方向。

在这场最先进技术的碰撞中,有不少令人期待的未来图景。

15 亿大模型,手机 12 秒跑完

几个月前,高通就曾在巴塞罗那 MWC 通信展上玩了一把手机跑 Stable Diffusion。此次对于终端侧生成式 AI,高通首先展示了完全在安卓手机上运行 ControlNet 图像生成图像模型,并实现了速度「全球最快」。

用时是多少呢?不到 12 秒。要知道,ControlNet 拥有 15 亿参数,而二月份高通演示在手机上运行 10 亿参数的 Stable Diffusion,当时还花了 15 秒左右。

这让人不得不感叹,终端侧的生成式 AI 能力又进化了。

作为一种生成式 AI 绘画解决方案,ControlNet 被认为是扩散模型中的大杀器,它通过额外输入控制预训练大模型如 Stable Diffusion,可以精细地设定生成图像的各种细节。先输入一张参考图,然后根据输入的 prompt 进行预处理,就能对生成的图像进行精准控制。

此次在高通 AI Research 的展示中,普通安卓手机仅用 11.26 秒便可以运行 ControlNet 生成一张图片,并且无需访问任何云端,完全本地化,交互式体验良好且运行非常高效。下面是一个动图演示:

图片

图片

我们知道,AI 画图的教程里通常会有对计算机配置的建议,在 ControlNet 上训练需要 16G 显存的 GPU,而推理用 M1 芯片需要 5 到 10 分钟,高通却能让手机做到效率更高,这是如何实现的呢?

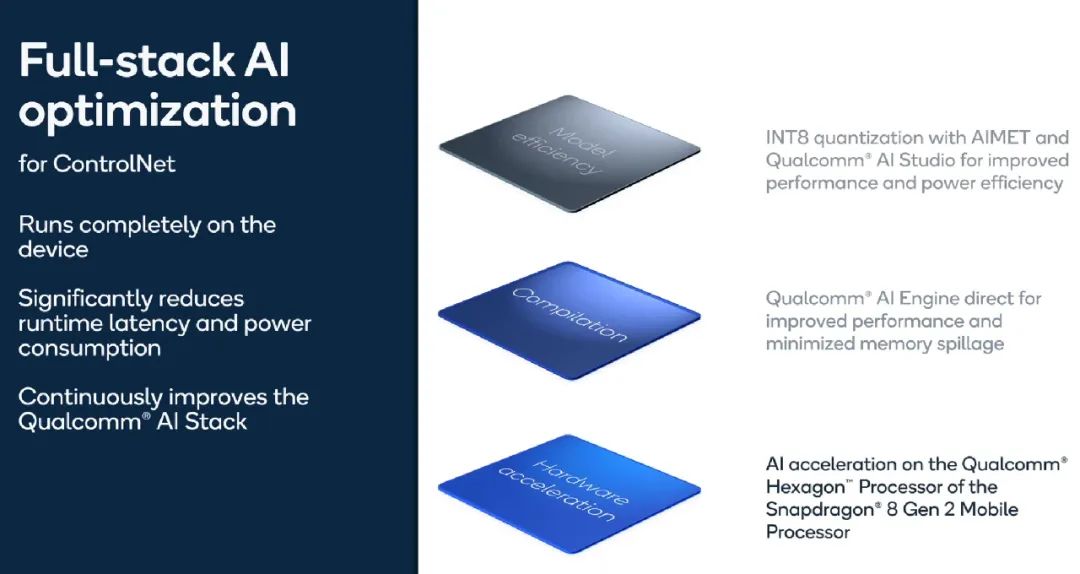

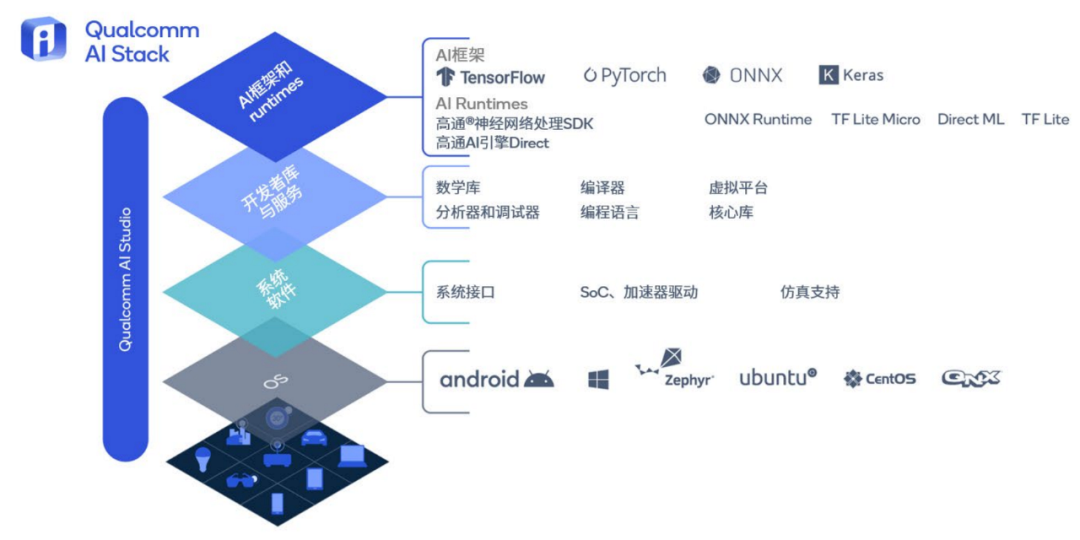

高通此次对 ControlNet 模型架构进行了软硬件全栈式 AI 优化,以低功耗、低延迟地实现高质量图像生成。其中用到的关键 AI 工具和软硬件包括了高通 AI 模型增效工具包(AIMET)、高通 AI 引擎和高通 AI 软件栈。我们一一来看。

图片

图片

首先是 AIMET,它是高通创新中心推出的端侧 AI 模型效率工具包,能够提供模型量化和压缩服务,通过量化感知训练,将浮点运算模型转化为整数运算模型。此处高通利用 AIMET 及 Qualcomm AI Studio 完成 ControlNet 模型的 INT8 量化压缩,节省更多功耗,提升运行效率。

其次是高通 AI 引擎,它是高通终端侧 AI 优势的核心,采用异构计算机构,包括高通 Hexagon 处理器、Adreno GPU 和 Kryo CPU。目前高通第二代骁龙 8 搭载了迄今最快、最先进的高通 AI 引擎。ControlNet 正是在第二代骁龙 8 的高通 Hexagon 处理器上,完成了 AI 加速。

还有高通 AI 软件栈负责应用的构建、优化和部署。在跑 ControlNet 时,高通 AI 引擎 Direct 框架基于 Hexagon 处理器的硬件架构和内存层级进行运算排序,提升性能并最小化内存溢出,降低运行时延和功耗。

图片

图片

这么一套集 AI 模型压缩工具、硬件和软件框架于一体的全栈式优化下来,在手机上十几秒跑大模型的不可能变成了可能。

接近落地,可以展示

除了给 AI 绘画做移动版优化,高通还在数字人、神经网络视频编解码等其他技术方向进一步探索 AI 能力的延展。

在 CVPR 上,利用基于视觉的大语言模型(LLM),高通打造了一个「数字健身教练」,它能够与用户实时互动,像真人教练一样给予鼓励,还能纠正并帮助达成自己的健身目标。既然是大模型驱动,AI 教练实现了极强的互动性,看起来健身私教要开始焦虑了。

图片

图片

在技术上,数字健身教练将用户的运动视频流交给动作识别模型进行处理,根据识别的动作提供提示并反馈给大模型。然后健身教练通过一个文本生成语音的数字化身,将 AI 的答复反馈回用户。

得益于大模型的能力,数字化身能够实时、不间断地为用户提供相关的健身反馈,比如「你的形体看起来棒极了」、「你的双臂应与肩膀同宽」。

现在看起来和 AI 训练就不能偷懒了,它会对用户的健身互动进行评估,给出你的耐力、强度和形体分数,还告诉完成了多少组动作。同时也会给用户提出相关建议。

图片

图片

与此同时,在神经网络视频编码这一技术方向,高通又实现一个「全球首次」。同样是在手机端,高通首创了 1080p 的视频编码和解码过程。

对于神经网络编解码而言,它可以针对特定视频需求进行定制,并运行在通用 AI 硬件上。在计算能力有限的终端设备上实现高分辨率(如 1080p、2k 等),则要借助 AI 算法的创新。

高通全新设计了高效的神经网络视频帧间压缩架构,在搭载骁龙芯片的手机设备上,实现了 1080p 的视频编解码,视频解码速率也来到了每秒 35 帧上下,并且能够保留丰富的视觉结构和复杂动作。

图片

图片

看起来,移动端生成式 AI、神经视觉编码领域的很多技术已接近应用层,落地的速度追上了 GPT 系列更新的速度。高通在做的事,解决了生成式 AI 面临的大问题。

看起来,移动端生成式 AI、神经视觉编码领域的很多技术已接近应用层,落地的速度追上了 GPT 系列更新的速度。高通在做的事,解决了生成式 AI 面临的大问题。

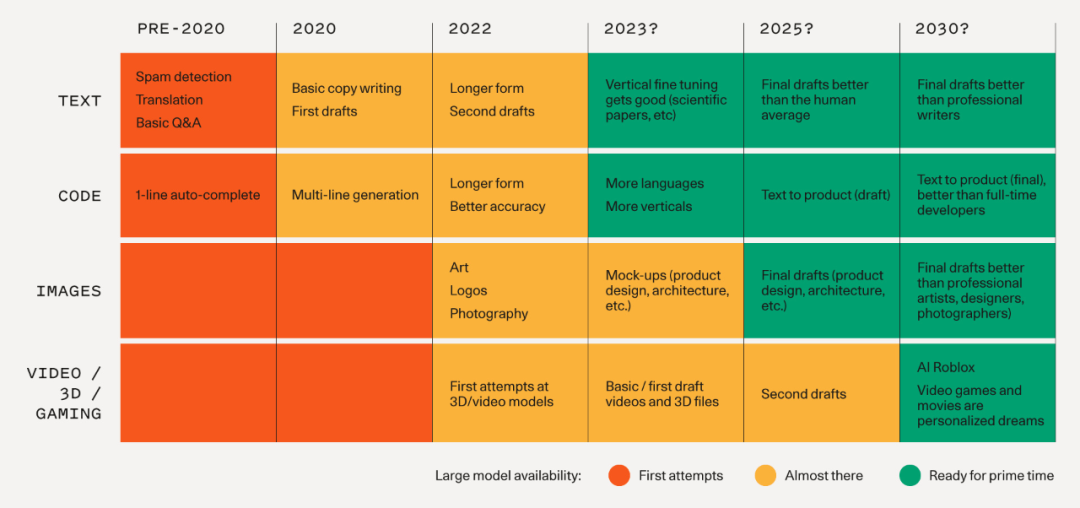

生成式 AI 的未来在端侧

我们知道,生成式 AI 有重塑所有行业的潜力,人工智能正在经历自己的闪耀时刻,问题在于:生成式 AI 虽然更聪明,但也更耗费算力。

有研究表示,每次基于生成式 AI 的网络搜索查询(query),其成本是传统搜索的 10 倍。全球每天都有超过 100 亿次搜索请求,而且,移动端的搜索占比超过了 60%。

除了要买更多 GPU,我们更要考虑的是如何能让大模型跑在手机上 —— 毕竟大家每天在用的都是端侧设备。

对此,高通已有一个整体的规划。今年 4 月,高通通过介绍「混合 AI」的概念,提出了大模型等 AI 任务处理在云端和终端共同进行的范式。

所谓混合 AI,是指充分利用边缘侧终端算力支持生成式 AI 应用的方式,相比仅在云端运行的 AI,前者能够带来高性能、个性化且更安全的体验。

在其愿景下,我们根据 AI 模型和查询需求的复杂度等因素,选择不同方式在云端和终端侧之间分配负载:如果模型、提示或生成内容的长度小于某个限定值,且精度足够,推理就可以完全在终端侧进行;如果任务相对复杂,则可以部分依靠云端模型;如果需要更多实时内容,模型也可以接入互联网获取信息。

图片

图片

在未来,不同的生成式 AI 用不同分流方式的混合 AI 架构,AI 也能在此基础上持续演进:

- 大量生成式 AI 的应用,比如图像生成或文本创作,需求 AI 能够进行实时响应。在这种任务上,终端可通过运行不太复杂的推理完成大部分任务。

- 在终端设备充当「感知器官」的任务中,终端负责初步处理任务,云端运行大模型将生成的内容发回端侧,这种操作节省了算力需求和带宽。

- 终端和云端的 AI 计算也可以协同工作来处理 AI 负载。在大模型的工作过程中,每次推理生成的标记(token)都需要读取全部参数才能完成,使用闲置算力通过共享参数来推测性并行运行大语言模型,可以提升性能并降低能耗。

最后,混合 AI 还支持模型在终端侧和云端同时运行,也就是在终端侧运行轻量版模型时,在云端并行处理完整模型的多个 token,并在需要时更正终端侧的处理结果。

混合 AI 覆盖的边缘终端包括智能手机、汽车、个人电脑和物联网终端设备,或许会成为未来生成式 AI 应用的标准。

但如何做到混合 AI ?对此,必须对 AI 的全栈进行优化。在生成式 AI 出现以前,高通就在推动 AI 处理向边缘进行转移。很多的日常功能,都是利用终端侧 AI 进行支持的,如暗光拍摄、降噪和人脸解锁。

如今,高通已构建起业界领先的硬件和软件解决方案,从端侧芯片上的高通 AI 引擎,云端专用芯片,到将其统一在一起的异构计算机制,在运行 AI 负载时,高通现在已可以充分利用硬件和软件来加速终端侧 AI 的推理速度。

而在部署时,利用高通 AI 软件栈,开发者可以充分发挥高通 AI 引擎性能,并实现多端部署,模型构建一次,就可以应用到多种不同硬件上。

图片

图片

在高通的业务中,低功耗、高性能的 AI 已经形成了横跨智能手机、汽车、XR、PC 和企业级 AI 等领域的庞大终端 AI 生态系统。从拍照,语音助手,到增强 5G 信号的黑科技,持续利用先进 AI 技术,让这家公司保持了市场领先的地位。

在这背后,是高通 AI Research 对 AI 研究超过 15 年的持续投入。高通一直致力于 AI 基础技术的研究,从感知、推理再到认知,我们见证了终端 AI 技术的不断拓展。而在这个过程中,由高通发表的 AI 论文也逐渐影响了整个行业。

图片

图片

仅在生成式 AI 上,最初高通探索了生成式模型的压缩方式,并进一步提升了生成痕迹(Artifact)的感知效果,其利用 VAE 技术创建的视频和语音编解码器,将模型规模控制在了 1 亿参数以下。高通还将生成式 AI 理念延伸到无线领域来替代信道模型,提高了手机通信的效率。

CVPR 2023 上展示的技术,是高通生成式 AI 布局的重要一环。随着端侧 AI 计算能力的持续优化,混合 AI 的潜力将会进一步被释放。预计在未来几个月,高通还要在手机上部署超过 100 亿参数的大模型。

生成式 AI 可以打造全新体验,变革生产力水平,高通在边缘侧以低功耗运行生成式 AI 的独特专长,让生成式 AI 具有了融入人们日常生活的可行性。这些能力将会跟随全球出货的数十亿块芯片,很快进入到人们的手中。

在本周上海举行的世界人工智能大会 WAIC 上,高通将会有多位高管参与演讲,并有望在现场展示移动端运行 Stable Diffusion、ControlNet 等能力,让来看展的人可以近距离接触一下未来。